Recentemente, Meta ha lanciato iniziative legate alla gestione dei dati che hanno sollevato discussioni globali nel bene e nel male: da un lato ha introdotto Thrive, un programma per condividere dati relativi a contenuti suicidi e di autolesionismo tra piattaforme social, mentre dall’altro è stata criticata per l’uso di foto pubbliche di minori australiani per l’addestramento dei propri modelli di intelligenza artificiale senza un’opzione di consenso esplicito.

Meta lancia il programma “Thrive” per affrontare i contenuti suicidi

Meta ha collaborato con la Mental Health Coalition per lanciare Thrive, un programma che consente alle piattaforme social, tra cui Snap e TikTok, di condividere segnali relativi a contenuti che violano le norme sui suicidi e l’autolesionismo. L’iniziativa mira a impedire la diffusione di contenuti pericolosi tra piattaforme diverse, utilizzando un sistema di condivisione di “hash”, ovvero codici numerici che rappresentano immagini o video violenti, senza rivelare informazioni personali sugli utenti.

Tra aprile e giugno 2024, Meta ha rimosso più di 12 milioni di contenuti relativi a suicidi o autolesionismo su Facebook e Instagram. Questo programma rappresenta un passo avanti nella prevenzione della diffusione di contenuti dannosi attraverso una collaborazione tra diverse piattaforme tecnologiche.

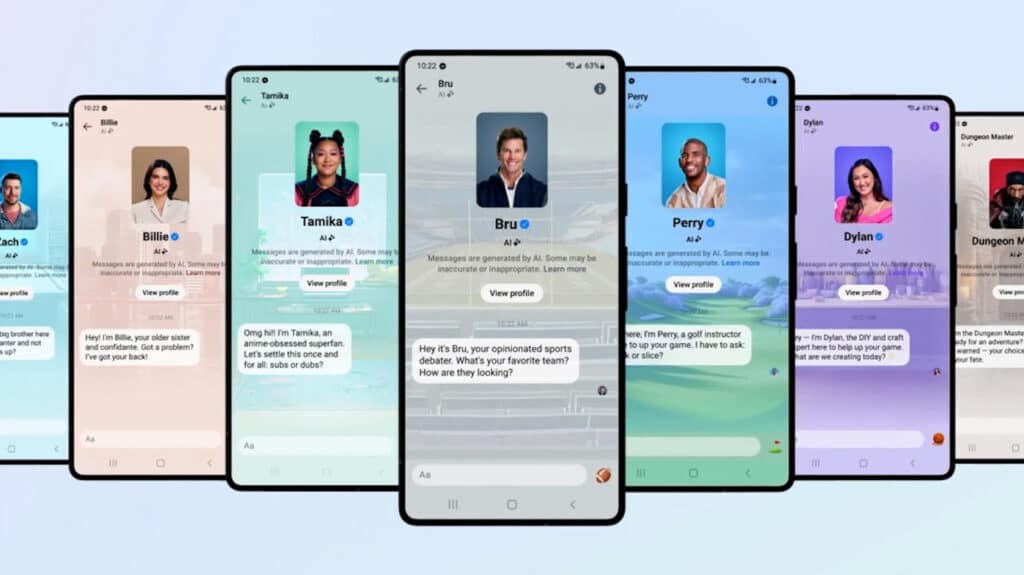

Meta utilizza foto di bambini australiani per l’addestramento dell’IA

Parallelamente, Meta è stata al centro di una controversia in Australia, dove è emerso che l’azienda sta raccogliendo foto e post pubblici dagli account di utenti australiani per addestrare i propri modelli di intelligenza artificiale. Diversamente dall’Unione Europea, gli australiani non hanno la possibilità di rifiutare esplicitamente questo utilizzo dei loro dati. Durante un’inchiesta, è stato confermato che Meta raccoglie foto di bambini dalle pagine pubbliche dei profili dei genitori per addestrare le sue IA, suscitando preoccupazioni in merito alla privacy.

Questa pratica ha sollevato interrogativi sull’uso di immagini di minori, in particolare per quegli utenti che hanno creato i propri account prima dei 18 anni. Sebbene Meta affermi di non raccogliere i dati di chi è attualmente minorenne, le immagini di coloro che lo erano all’epoca della creazione del loro account sono potenzialmente soggette a questa raccolta.

Mentre Meta si impegna a combattere contenuti dannosi come quelli legati ai suicidi, le sue pratiche di raccolta dati per l’addestramento dell’intelligenza artificiale sollevano gravi questioni sulla privacy. L’introduzione di strumenti come Thrive rappresenta un progresso nella protezione degli utenti, ma le critiche sulle politiche di raccolta dei dati pubblici richiedono maggiore attenzione, specialmente per quanto riguarda i minori.