Sommario

In un panorama mediatico in continua evoluzione, le piattaforme social giocano un ruolo cruciale nel modellare il dialogo pubblico e la sicurezza online. Recentemente, due eventi hanno catalizzato l’attenzione generale, evidenziando le sfide e le responsabilità di queste piattaforme. Da un lato, X (precedentemente noto come Twitter) ha adottato misure drastiche bloccando le ricerche relative a Taylor Swift in risposta alla diffusione di immagini false create tramite intelligenza artificiale. Dall’altro, l’azienda annuncia l’apertura di un nuovo ufficio per la moderazione dei contenuti ad Austin, Texas, puntando a rafforzare la sua lotta contro lo sfruttamento sessuale dei minori. Questi sviluppi sollevano interrogativi importanti sull’equilibrio tra libertà di espressione, sicurezza degli utenti e le implicazioni etiche della tecnologia AI.

X Blocca le Ricerche di Taylor Swift: Misura Temporanea o Soluzione?

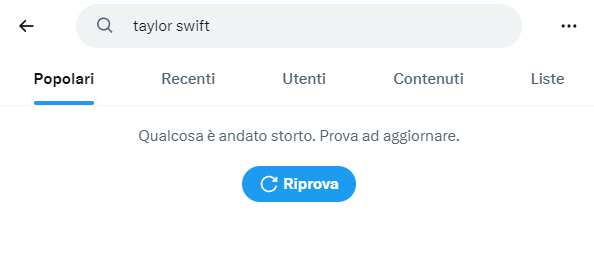

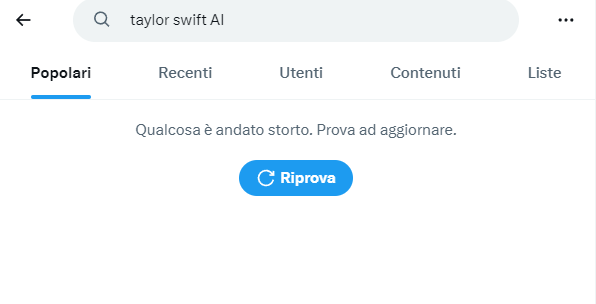

X ha bloccato le ricerche relative a Taylor Swift in risposta a una recente ondata di immagini false create tramite intelligenza artificiale che ritraevano in maniera grafica la nota artista internazionale. Attualmente, cercando “Taylor Swift” o “Taylor Swift AI” su X, precedentemente noto come Twitter, potrebbe apparire un messaggio di errore. Joe Benarroch, responsabile commerciale di X, ha riconosciuto questa misura “temporanea”, volta a “prioritizzare la sicurezza”, secondo quanto riportato dal The Wall Street Journal.

Tuttavia, abbiamo scoperto che è piuttosto facile aggirare il blocco semplicemente modificando leggermente la ricerca.

Strategie di Contenimento e Reazioni

Nonostante il tentativo di limitazione, le immagini continuano ad essere visibili nella sezione Media, anche per i termini altrimenti bloccati. X ha dichiarato di essere “attivamente impegnata nella rimozione di tutte le immagini identificate” e di aver preso provvedimenti contro gli account che le pubblicavano, in linea con il divieto esplicito della piattaforma contro la nudità non consensuale e i media sintetici o manipolati.

Taylor Swift sta valutando azioni legali contro i siti che ospitano tali immagini, preferibilmente create con Microsoft Designer. Satya Nadella, CEO di Microsoft, ha descritto i deepfake come “allarmanti e terribili”, sottolineando la necessità per le aziende di IA di “muoversi rapidamente” per implementare misure di sicurezza più efficaci.

X Stabilisce un Quartier Generale per la Moderazione dei Contenuti ad Austin

X ha annunciato l’assunzione di 100 dipendenti a tempo pieno per un nuovo ufficio di fiducia e sicurezza ad Austin, Texas, in vista della testimonianza del CEO Linda Yaccarino prevista per il 31 gennaio davanti al Comitato Giudiziario del Senato riguardo alla moderazione dei contenuti di sfruttamento sessuale dei minori su X. Questo team si concentrerà principalmente su CSE (Child Sexual Exploitation) e rappresenterà la prima vera squadra di fiducia e sicurezza dall’acquisizione della piattaforma da parte di Elon Musk.

Iniziative e Implicazioni

Nonostante la mancanza di dettagli specifici sulle attività del nuovo team e sulla data di apertura dell’ufficio, l’iniziativa segna un passo importante nella lotta contro lo sfruttamento sessuale online. Joe Benarroch, capo delle operazioni commerciali di X, ha dichiarato che il team contribuirà anche ad altre aree di moderazione dei contenuti, come il discorso d’odio. Un annuncio di lavoro per la moderazione dei contenuti a Austin indica che i moderatori si occuperanno di questioni come spam, frodi e forniranno supporto ai clienti.

Mentre il blocco delle ricerche di Taylor Swift da parte di X rappresenta un tentativo di mitigare gli effetti nocivi dei contenuti generati dall’intelligenza artificiale, l’istituzione di un quartier generale per la moderazione dei contenuti ad Austin segnala un impegno più ampio nell’affrontare problemi di sicurezza online critici come lo sfruttamento sessuale dei minori. Queste azioni riflettono la crescente pressione sulle piattaforme social per assumersi la responsabilità del contenuto che ospitano e per sviluppare soluzioni proattive per proteggere i loro utenti. Mentre le strategie adottate suscitano dibattiti sull’efficacia e sulle possibili conseguenze non intenzionali, è chiaro che il percorso verso un ambiente digitale più sicuro richiede uno sforzo congiunto tra le aziende tecnologiche, gli utenti e i regolatori.