Sommario

Cerebras Systems ha svelato il suo Wafer Scale Engine 3 (WSE-3), proclamato come “il chip AI più veloce al mondo”. Questo gigantesco chip, cuore del supercomputer AI Cerebras CS-3, segna una svolta nella capacità di addestramento dei modelli AI, con prestazioni raddoppiate rispetto al suo predecessore, il WSE-2, mantenendo lo stesso consumo energetico e prezzo.

Caratteristiche rivoluzionarie del WSE-3

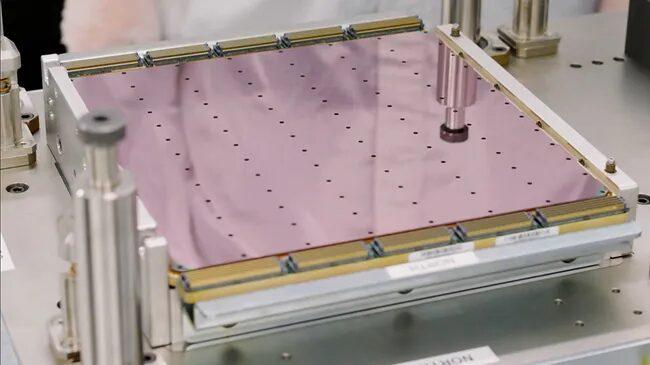

Il WSE-3, realizzato con un processo a 5nm di TSMC, si distingue per i suoi quattro trilioni di transistor e 900.000 core ottimizzati per l’AI, che insieme erogano una performance AI di picco di 125 petaflops. Questo equivale teoricamente a circa 62 GPU Nvidia H100. Con 44GB di SRAM integrata, il WSE-3 è in grado di addestrare modelli AI con fino a 24 trilioni di parametri, un balzo significativo rispetto ai modelli precedenti.

Il supercomputer CS-3

Il CS-3, alimentato dal WSE-3, è progettato per addestrare modelli AI di nuova generazione che sono 10 volte più grandi di GPT-4 e Gemini. Con un sistema di memoria fino a 1.2 petabyte, può teoricamente memorizzare modelli da 24 trilioni di parametri in un unico spazio di memoria logico, semplificando il flusso di lavoro di addestramento e aumentando la produttività degli sviluppatori.

Cerebras afferma che il suo supercomputer CS-3 è ottimizzato sia per le esigenze aziendali che iperscalari, offrendo un’efficienza energetica superiore e una semplicità software, richiedendo il 97% in meno di codice rispetto alle GPU per grandi modelli linguistici (LLM).

Futuro promettente

Andrew Feldman, CEO e cofondatore di Cerebras, ha dichiarato: “Il WSE-3 è il chip AI più veloce al mondo, creato appositamente per i lavori AI all’avanguardia. Siamo entusiasti di portare sul mercato il WSE-3 e il CS-3 per aiutare a risolvere le più grandi sfide dell’AI di oggi”.

Cerebras ha già un backlog di ordini per il CS-3 in vari settori, compresi quelli aziendali, governativi e cloud internazionali. Il CS-3 avrà anche un ruolo significativo nella partnership strategica tra Cerebras e G42, che ha già fornito 8 exaFLOPs di prestazioni di supercomputer AI tramite Condor Galaxy 1 e 2. Una terza installazione, Condor Galaxy 3, è attualmente in costruzione e sarà realizzata con 64 sistemi CS-3, producendo 8 exaFLOPs di calcolo AI.