Sommario

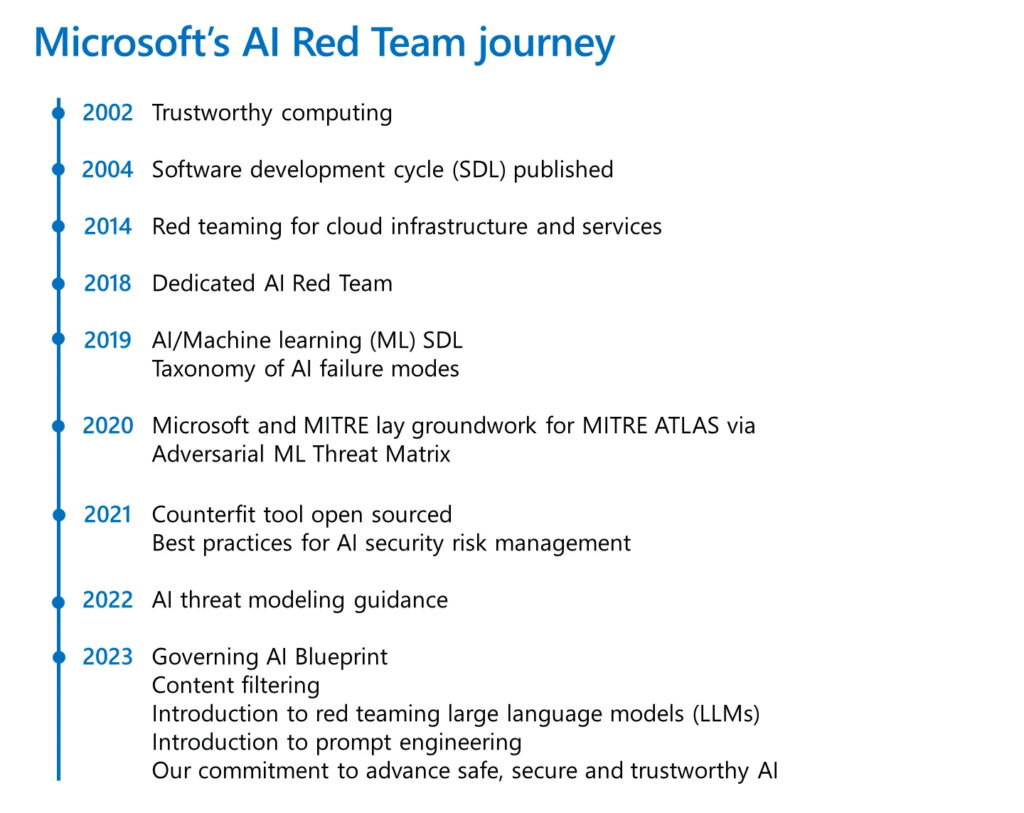

Il red teaming è una componente essenziale per la distribuzione sicura del software. Microsoft, con una lunga storia di red teaming per le tecnologie emergenti, ha istituito nel 2018 il “Red Team AI”, un gruppo di esperti interdisciplinari dedicato all’analisi dei sistemi AI alla ricerca di potenziali vulnerabilità.

Il ruolo del Red Team AI

Il red teaming AI ha assunto un significato più ampio, non limitandosi alla ricerca di vulnerabilità di sicurezza, ma estendendosi anche ad altri tipi di fallimenti del sistema, come la generazione di contenuti potenzialmente dannosi. Questa pratica è fondamentale per comprendere i nuovi rischi associati ai sistemi AI, come l’iniezione di prompt e la produzione di contenuti non fondati. Microsoft ha recentemente annunciato che tutti i sistemi AI ad alto rischio saranno sottoposti a red teaming indipendente prima del loro lancio.

Red teaming per una maggiore sicurezza nell’implementazione AI

Negli ultimi anni, il Red Team AI di Microsoft ha condiviso contenuti per aiutare i professionisti della sicurezza a implementare l’AI in modo sicuro. Nel 2020, Microsoft ha collaborato con MITRE e altri partner per sviluppare il “Matrix delle minacce all’apprendimento automatico avversario”, un framework per aiutare gli analisti di sicurezza a rilevare e rispondere alle minacce. Microsoft ha anche creato e reso open source “Counterfit”, uno strumento per testare la sicurezza dei sistemi AI. Nel 2021, è stato rilasciato un framework di valutazione del rischio di sicurezza AI, seguito da ulteriori collaborazioni per aiutare le organizzazioni a comprendere i rischi associati ai sistemi AI.

Guida e risorse per il red teaming

Il red teaming AI si svolge generalmente a due livelli: a livello di modello base (ad esempio, GPT-4) o a livello di applicazione. Entrambi i livelli offrono vantaggi specifici, come la comprensione delle limitazioni del modello o l’identificazione di fallimenti a livello di applicazione. Microsoft ha condiviso diverse lezioni apprese dal suo programma Red Team AI, tra cui:

- Il red teaming AI è più ampio: copre sia la sicurezza che gli esiti RAI.

- Si concentra su fallimenti da persone malintenzionate e benigne: ad esempio, come un sistema può generare contenuti problematici durante interazioni normali.

- I sistemi AI sono in costante evoluzione: richiedendo cicli multipli di red teaming.

- Il red teaming di sistemi AI generativi richiede tentativi multipli: a causa della loro natura probabilistica.

- Mitigare i fallimenti AI richiede una difesa in profondità: come l’uso di classificatori o la limitazione della deriva conversazionale.

Microsoft è impegnata nella costruzione di tecnologia in modo responsabile e sicuro. Con l’AI che si profila come la tecnologia più trasformativa del 21° secolo, la sicurezza e la responsabilità sono al centro degli sforzi dell’azienda. Il Red Team AI gioca un ruolo cruciale in questo contesto, garantendo che i prodotti AI siano sicuri e affidabili.