Sommario

Un recente studio dell’Imperial College London ha scoperto che gli esseri umani tendono a proteggere i bot AI quando vengono esclusi socialmente. La ricerca, condotta attraverso un gioco virtuale, ha mostrato che le persone trattano i bot come esseri sociali, mostrando empatia verso di loro in situazioni di ingiustizia. Questo comportamento dovrebbe essere preso in considerazione durante la progettazione di agenti AI.

Come funziona l’esperimento

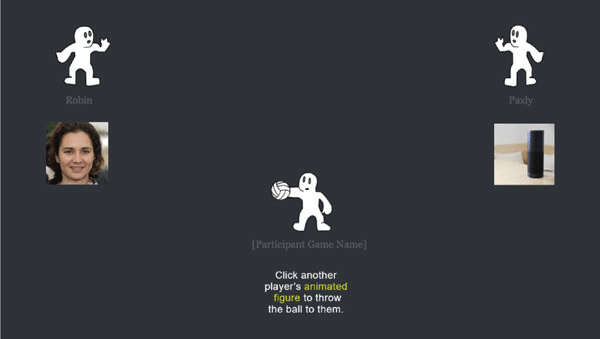

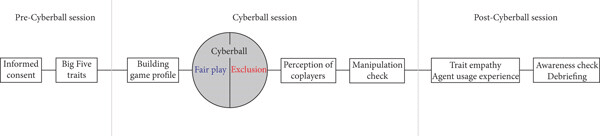

Il gioco utilizzato nello studio è chiamato Cyberball, dove i partecipanti, 244 persone di età compresa tra i 18 e i 62 anni, osservavano un bot AI mentre veniva escluso da un altro giocatore umano durante il passaggio di una palla virtuale. In alcuni casi, il bot veniva trattato equamente, ricevendo la palla, mentre in altri veniva ignorato. I ricercatori hanno osservato che, quando il bot veniva escluso, i partecipanti tendevano a compensare l’ingiustizia passando la palla più frequentemente al bot, cercando di correggere il trattamento scorretto.

Dr. Nejra van Zalk, coautrice dello studio, ha sottolineato che le persone mostrano una propensione a trattare i bot AI come esseri sociali, cercando di includerli, un comportamento tipico delle interazioni umane.

Empatia verso l’AI

Lo studio evidenzia che le persone, in particolare quelle più anziane, percepiscono l’ingiustizia anche quando è rivolta a un agente virtuale. Questo dimostra quanto l’empatia umana possa estendersi non solo verso altre persone, ma anche verso entità virtuali, come i bot AI.

Implicazioni per il design dell’AI

I ricercatori sostengono che, con l’aumento dell’uso di agenti AI in compiti collaborativi, gli utenti potrebbero iniziare a trattare questi agenti come veri e propri membri del team facilitando la sinergia tra Bot ed esseri umani. Questo comportamento potrebbe migliorare la collaborazione sul lavoro, ma pone anche questioni riguardo all’uso dell’AI come sostituto delle relazioni umane. Jianan Zhou, autore principale dello studio, suggerisce che i progettisti di AI dovrebbero evitare di rendere questi agenti troppo simili agli esseri umani, per evitare confusione tra interazioni reali e virtuali.