Sommario

L’edizione 2025 di Google Cloud Next ha stabilito un nuovo punto di riferimento nella narrazione dell’innovazione tecnologica, incentrando tutti i principali annunci sull’estensione e il consolidamento dell’intelligenza artificiale come fondamento dell’intera infrastruttura informatica globale. La strategia esposta da Sundar Pichai e dai vertici di Google Cloud non si limita a potenziare strumenti già esistenti, ma ridefinisce radicalmente i livelli di interazione tra software, hardware, applicazioni aziendali, ricerca scientifica e gestione dei dati. Il cuore di questa trasformazione è rappresentato dalla famiglia di modelli Gemini, espansa e potenziata con l’introduzione delle varianti Gemini 2.5 e Gemini 2.5 Flash, pensate per garantire risposte rapide, flessibilità nell’elaborazione semantica e massima ottimizzazione dei costi.

A testimoniare l’impatto sistemico dell’approccio AI-first adottato da Google, è il dato secondo cui tutti i prodotti che superano il mezzo miliardo di utenti attivi, e ben sette con oltre due miliardi, utilizzano già le capacità avanzate dei modelli Gemini. Non si tratta più semplicemente di integrare funzioni di completamento testi o generazione di contenuti nei singoli strumenti, ma di costruire un’infrastruttura cognitiva distribuita che opera in tempo reale, apprende dal contesto e supporta ogni livello della produttività e dell’innovazione.

Gemini 2.5 Flash: velocità, efficienza e controllo del ragionamento

Tra i modelli presentati, Gemini 2.5 Flash si distingue per la sua bassa latenza operativa, per l’efficienza nei consumi computazionali e per la capacità di adattare il livello di “ragionamento” richiesto, calibrandolo in funzione degli obiettivi specifici. Questo modello non solo è pensato per rispondere alle esigenze delle imprese che gestiscono workload dinamici, ma anche per democratizzare l’accesso all’intelligenza generativa, offrendo una soluzione scalabile che consente l’uso ottimizzato di risorse, sia in termini economici che prestazionali. L’integrazione sarà graduale su Google AI Studio, Vertex AI e nella Gemini App, rendendo questa tecnologia accessibile a sviluppatori, team creativi, operatori del settore sanitario, educatori e aziende di ogni dimensione.

La novità consiste nella possibilità, attraverso un semplice parametro, di determinare il livello di profondità semantica e inferenziale che il modello dovrà impiegare nel rispondere. Questo consente di risparmiare tempo e risorse nei casi in cui l’output desiderato richiede una logica semplice e lineare, o viceversa di attivare tutte le potenzialità analitiche nei casi complessi, come la generazione automatica di reportistica specialistica o l’elaborazione di scenari predittivi.

Ironwood: il cuore computazionale dell’età dell’inferenza

Nel contesto di Google Cloud Next 2025, è stata annunciata una rivoluzione anche sul piano hardware con il debutto di Ironwood, la settima generazione delle Tensor Processing Unit (TPU) di Google. Si tratta della prima TPU progettata esclusivamente per l’inferenza, cioè per l’applicazione pratica dei modelli AI su larga scala, e non per il loro addestramento. Questo passaggio segna l’inizio di quella che è stata definita l’età dell’inferenza, una nuova fase nella quale i modelli AI non solo reagiscono alle richieste umane, ma anticipano, interpretano, correlano e producono decisioni in autonomia.

Ironwood è stata sviluppata per gestire i modelli AI più complessi in ambienti produttivi reali. Ogni chip è raffreddato a liquido e può essere collegato in architetture che comprendono fino a 9.216 unità, grazie alla nuova interconnessione proprietaria Inter-Chip Interconnect (ICI). Le prestazioni risultano cinque volte superiori rispetto alla generazione precedente, con sei volte la capacità di memoria HBM, garantendo prestazioni straordinarie, risparmio energetico e scalabilità estrema.

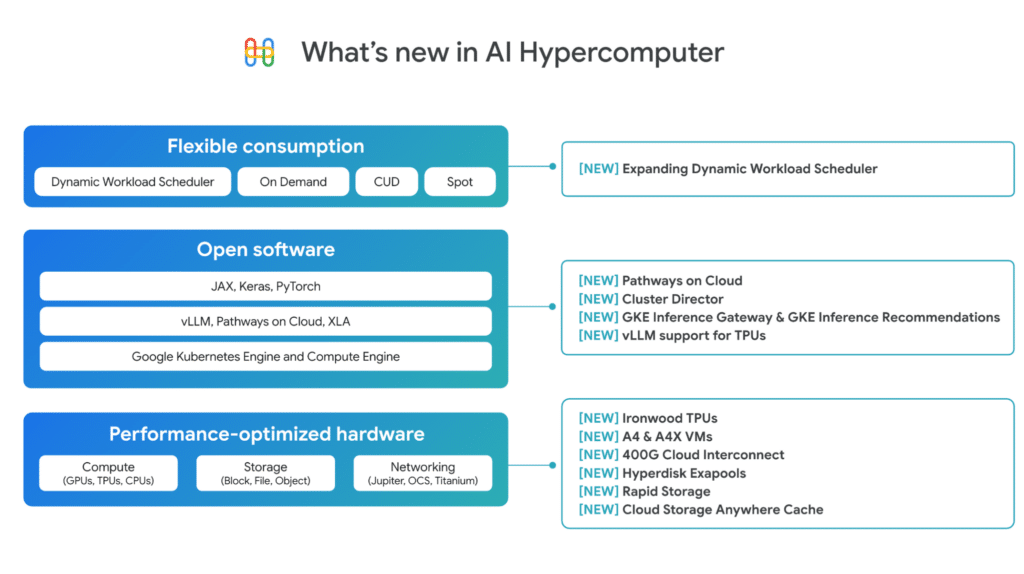

Questa infrastruttura non è solo uno strumento per le grandi aziende, ma diventa il nodo centrale del Google AI Hypercomputer, un’architettura che combina hardware e software in un’unica piattaforma capace di eseguire modelli complessi in tempo reale, rispondere a milioni di richieste al secondo e adattarsi ai cambiamenti nei dati e nel contesto.

Vertex AI: la piattaforma generativa per immagini, video, voce e musica

Un altro asse fondamentale dell’annuncio riguarda Vertex AI, che oggi si propone come l’unica piattaforma cloud integrata a supportare modelli generativi nei principali ambiti multimediali: video, immagine, voce e musica. Questo rende Google il primo provider a offrire un ambiente unificato per la creazione, il fine-tuning e il deployment di contenuti generati da AI in tutti i formati principali. L’integrazione dei modelli Lyria, Veo 2, Chirp 3 e Imagen 3 amplia significativamente le possibilità creative, permettendo, ad esempio, la produzione di brani musicali da prompt testuali, la generazione video con controllo avanzato della regia, la sintesi vocale su misura e la ricostruzione di immagini danneggiate tramite inpainting di nuova generazione.

Questi strumenti sono pensati per ambienti professionali ad alta intensità creativa, come agenzie pubblicitarie, case di produzione cinematografica, editori digitali e piattaforme di e-learning. Ma grazie alla struttura modulare di Vertex AI, anche le PMI e le startup possono accedere a funzionalità che fino a pochi mesi fa erano esclusivo appannaggio dei grandi laboratori di ricerca.

L’infrastruttura diventa semantica: verso un cloud cognitivo

La visione di Google Cloud non si limita alla potenza computazionale o all’efficienza dell’inferenza. L’obiettivo è costruire una piattaforma cognitiva distribuita, nella quale ogni elemento – dalla rete alla sicurezza, dai dati alla produttività – sia integrato in un ecosistema che apprende, migliora e anticipa i bisogni.

Ne è esempio la trasformazione di Workspace, dove l’integrazione di Gemini ha portato a nuove funzionalità avanzate. Tra queste spiccano la possibilità di generare podcast direttamente da documenti testuali in Google Docs, l’utilizzo dell’AI per raffinare automaticamente i testi, l’analisi predittiva in Sheets e la gestione semplificata dei flussi di lavoro grazie a Workspace Flows, una nuova modalità per creare workflows agentici intelligenti senza scrivere codice.

Agentspace e agenti intelligenti: l’evoluzione naturale dell’automazione

Una delle innovazioni più rilevanti emerse durante l’evento è rappresentata dal concetto di Agentic AI, un paradigma nel quale le entità digitali intelligenti non solo comprendono richieste e generano output, ma collaborano, decidono, agiscono e si adattano a contesti mutevoli. Google ha introdotto una piattaforma chiave per questa evoluzione: Agentspace, un ambiente che mette a disposizione degli utenti aziendali uno strumento per costruire agenti AI personalizzati e modulari.

A differenza dei modelli tradizionali, questi agenti sono progettati per funzionare in ambienti complessi, per gestire interazioni non lineari e per interfacciarsi con sistemi aziendali eterogenei. La disponibilità di un nuovo strumento denominato Agent Designer, che consente anche agli utenti senza competenze di sviluppo di progettare agenti attraverso interfacce visuali, segna un’importante democratizzazione della capacità di innovazione. Le aziende possono ora modellare in autonomia strumenti intelligenti capaci di supportare vendite, logistica, compliance, marketing, HR e tutte le funzioni strategiche.

Due nuovi agenti preinstallati, Deep Research e Idea Generation, sono stati presentati come esempio di come l’AI possa supportare attività di analisi e generazione di insight a partire da documentazione interna, archivi digitali, fonti web e dati operativi. Il tutto con l’obiettivo di ottimizzare i processi decisionali, ridurre i tempi di ricerca e valorizzare il patrimonio informativo aziendale.

NVIDIA e il confine tra cloud e on-premises: agentic AI a prova di privacy

Un tassello fondamentale della visione proposta da Google risiede nella collaborazione con NVIDIA, che consente l’esecuzione dei modelli Gemini anche in ambienti on-premises grazie alla piattaforma Blackwell e alla tecnologia di Confidential Computing. Questa partnership è pensata per rispondere a esigenze specifiche di settori regolati, come sanità, finanza, settore pubblico e difesa, dove la gestione dei dati sensibili richiede compliance con normative locali e garanzia di sovranità digitale.

Grazie all’infrastruttura HGX e DGX, i modelli Gemini possono essere ospitati all’interno di data center aziendali, mantenendo riservatezza totale sui prompt, protezione delle credenziali di accesso e tutela contro il reverse engineering. Il Confidential Computing assicura che nessuna componente esterna possa accedere alle informazioni scambiate tra modello e utente, rendendo possibile l’adozione di agenti intelligenti anche in contesti precedentemente inaccessibili all’AI generativa.

Il vantaggio non si limita alla sicurezza. L’esecuzione locale permette di ridurre la latenza, ottimizzare i costi di trasferimento dati e conservare le performance predittive, ampliando il margine di utilizzo dell’intelligenza artificiale in scenari mission-critical.

Supercomputing per la scienza: Google guida la nuova era della ricerca computazionale

Tra gli annunci che avranno impatto a lungo termine, vi è quello relativo alle H4D VMs, le macchine virtuali più potenti mai progettate da Google, pensate per rispondere alle esigenze di calcolo scientifico avanzato, modellazione molecolare, previsioni climatiche, ricerca genetica e sviluppo farmaceutico. Queste istanze computazionali, basate su processori AMD di nuova generazione, sono ottimizzate per ambienti HPC – High Performance Computing e possono essere utilizzate in cluster scalabili tramite le tecnologie Cluster Toolkit e Cluster Director, che ne semplificano la gestione, il provisioning e la manutenzione.

In ambito scientifico, Google Cloud ha sottolineato come queste tecnologie siano già in uso da parte di università come Harvard, che le impiega per lo studio delle malattie cardiovascolari e per lo sviluppo di terapie personalizzate basate su simulazioni dinamiche.

La componente di storage avanzato, spesso sottovalutata nei workload scientifici, è garantita dal nuovo Google Cloud Managed Lustre, un file system parallelo ad altissime prestazioni basato su tecnologia EXAScaler in collaborazione con DDN. Questo sistema consente la lettura e scrittura simultanea da migliaia di nodi, con prestazioni adatte a sostenere addestramento di modelli di intelligenza artificiale su scala industriale e analisi di dataset multi-petabyte.

Workspace: produttività, automazione e intelligenza generativa quotidiana

L’AI diventa anche strumento quotidiano per il lavoro grazie all’evoluzione di Google Workspace. Le funzionalità integrate nei principali strumenti – da Docs a Sheets, passando per Chat e Meet – dimostrano come l’intelligenza artificiale possa migliorare drasticamente efficienza operativa, qualità dei contenuti e velocità decisionale.

Una delle innovazioni più interessanti è la possibilità di trasformare documenti testuali in contenuti audio, inclusi formati podcast, offrendo nuove modalità di fruizione interna dei materiali aziendali e aumentando l’accessibilità dei contenuti. Inoltre, la nuova funzione “Help me refine” consente la revisione intelligente dei testi, suggerendo miglioramenti sintattici, lessicali e stilistici basati sul contesto.

In ambito tabellare, Google Sheets integra una capacità avanzata di analisi dei dati che può rilevare trend, outlier e pattern significativi anche in assenza di formule complesse. Questa funzione, alimentata da Gemini, permette anche agli utenti meno esperti di estrarre valore strategico da database interni.

Infine, l’introduzione di Workspace Flows abilita la creazione di workflow automatizzati intelligenti, attivabili su trigger o condizioni specifiche, rendendo possibile la digitalizzazione di processi aziendali ricorrenti senza necessità di sviluppo software.

Sicurezza, rete e resilienza: il cloud diventa cervello operativo dell’impresa

La spinta verso l’unificazione dell’architettura ha trovato espressione anche nel rilascio di Google Unified Security, una nuova soluzione che integra prodotti per l’intelligence sulle minacce, la sicurezza operativa, la protezione del cloud e la navigazione sicura aziendale. Grazie all’integrazione dell’AI in ogni punto di controllo, il sistema può identificare, correlare e neutralizzare minacce anche complesse, con tempi di risposta significativamente ridotti.

A completare l’ecosistema, Cloud WAN espande l’accesso alla rete globale a bassa latenza di Google, la stessa che alimenta Search, Gmail e YouTube, rendendola ora disponibile per l’interconnessione aziendale. In questo modo, le aziende possono beneficiare di prestazioni di rete paragonabili a quelle interne a Google, garantendo tempi di risposta minimi, stabilità e scalabilità nelle comunicazioni internazionali.