Sommario

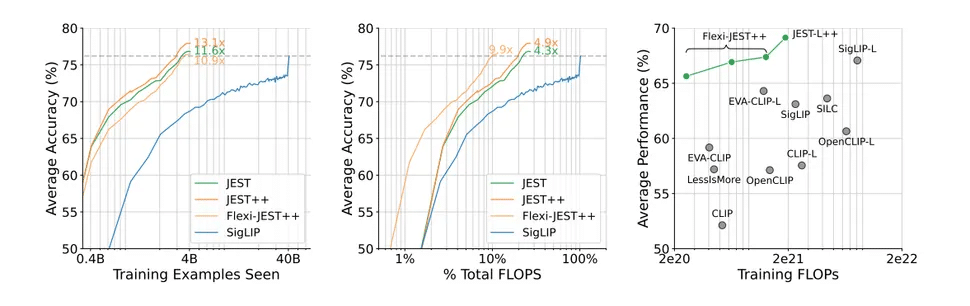

Google DeepMind, il laboratorio di ricerca sull’intelligenza artificiale di Google, ha annunciato una nuova tecnica di addestramento per modelli AI che promette di accelerare drasticamente la velocità di addestramento e migliorare l’efficienza energetica chiamata JEST (Joint Example Selection). La tecnologia è stata sviluppata per ottimizzare la selezione dei dati di addestramento, ottenendo risultati impressionanti: 13 volte più veloce e 10 volte più efficiente in termini di consumo energetico rispetto ai metodi tradizionali.

Come funziona il Metodo JEST

Il metodo JEST si distingue dai tradizionali approcci di addestramento AI concentrandosi sui lotti di dati anziché sui singoli punti dati. Ecco una panoramica del processo:

- Creazione di un Modello AI Ridotto: Viene creato un piccolo modello AI che valuta la qualità dei dati da fonti di altissima qualità.

- Valutazione dei Lotti di Dati: Questo modello ridotto classifica i lotti di dati in base alla qualità e li confronta con un set più ampio e di qualità inferiore.

- Selezione dei Lotti per l’Addestramento: Il modello JEST seleziona i lotti di dati più adatti per l’addestramento, che vengono poi utilizzati per addestrare un modello più grande.

Questo approccio permette di ridurre drasticamente il numero di iterazioni necessarie per l’addestramento e il consumo di calcolo, rendendo il processo molto più efficiente.

Vantaggi e sfide

I risultati ottenuti con il metodo JEST sono notevoli. DeepMind afferma che il loro approccio supera i modelli allo stato dell’arte con fino a 13 volte meno iterazioni e 10 volte meno calcolo. Tuttavia, questa metodologia dipende fortemente dalla qualità dei dati di addestramento iniziali. Senza un dataset ben curato, l’efficacia del metodo JEST può diminuire significativamente, rendendo essenziale la selezione accurata dei dati di partenza.

Impatto ambientale e sostenibilità

La ricerca di DeepMind arriva in un momento cruciale, poiché l’industria tecnologica e i governi mondiali stanno discutendo l’enorme impatto energetico dei data center AI. Nel 2023, i carichi di lavoro AI hanno consumato circa 4,3 GW di energia, un consumo paragonabile a quello di un piccolo paese come Cipro. Con previsioni che indicano che l’AI potrebbe occupare un quarto della rete elettrica degli Stati Uniti entro il 2030, metodi di addestramento più efficienti come JEST potrebbero rappresentare una soluzione vitale per ridurre l’impatto ambientale dell’AI.

Prospettive future

Rimane da vedere se e come i principali attori del settore AI adotteranno i metodi JEST. Il costo per addestrare modelli di intelligenza artificiale sta aumentando vertiginosamente, con GPT-4o che avrebbe costato 100 milioni di dollari per essere addestrato. Con modelli futuri che potrebbero raggiungere il miliardo di dollari, le aziende sono alla ricerca di modi per ridurre i costi senza compromettere le prestazioni. L’adozione del metodo JEST potrebbe rappresentare una svolta, permettendo di mantenere alti i tassi di produttività dell’addestramento riducendo al contempo il consumo energetico come illustrato approfonditamente nella ricerca.