Sommario

Un team di ricercatori dell’Università di Waterloo ha sviluppato un nuovo metodo di machine learning che rileva il linguaggio d’odio sulle piattaforme di social media con un’accuratezza dell’88%, risparmiando agli operatori centinaia di ore di lavoro emotivamente dannoso.

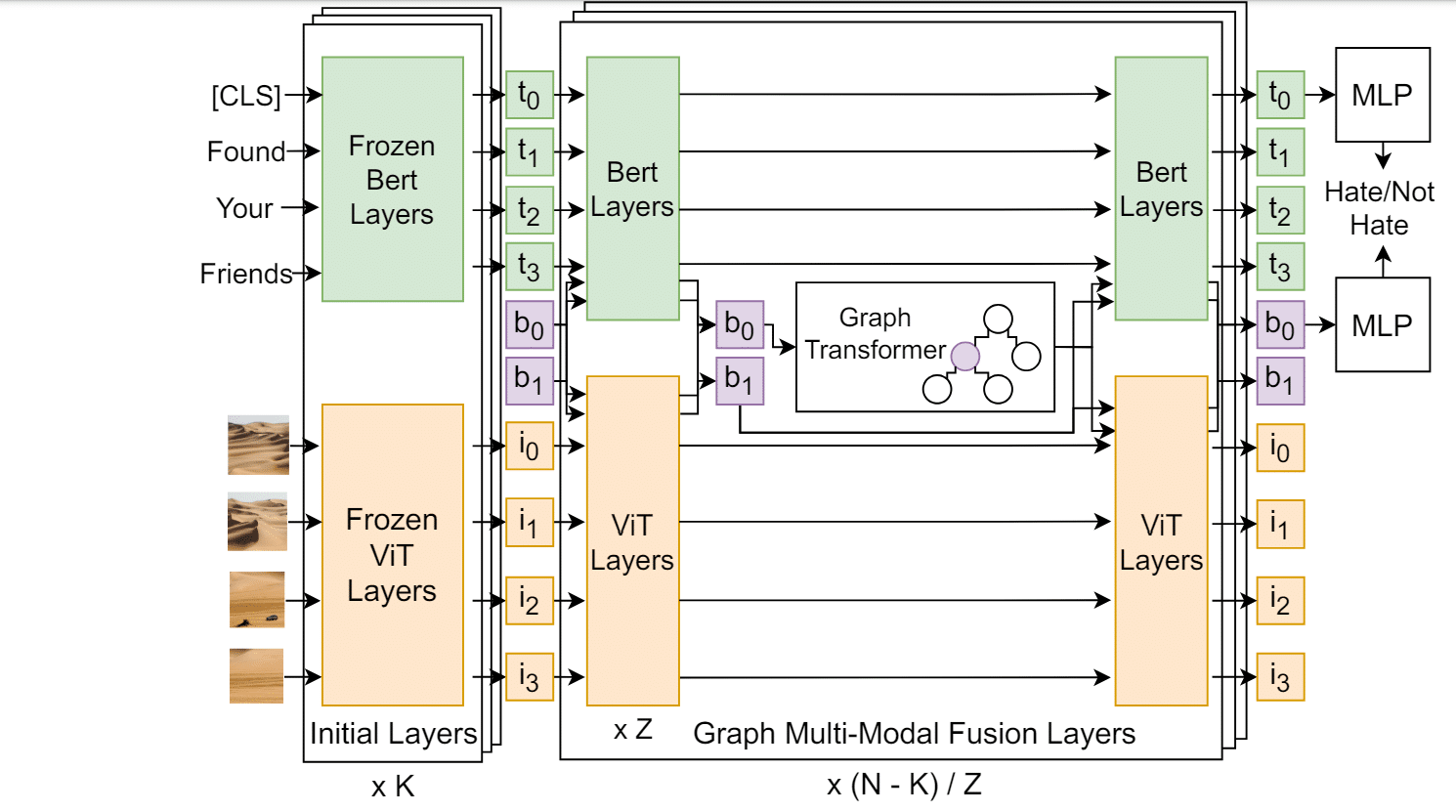

Il metodo, chiamato Multi-Modal Discussion Transformer (mDT), è in grado di comprendere la relazione tra testo e immagini e di contestualizzare i commenti, a differenza dei precedenti metodi di rilevamento del linguaggio d’odio. Questo approccio è particolarmente utile nel ridurre i falsi positivi, che spesso vengono segnalati erroneamente come linguaggio d’odio a causa di linguaggi culturalmente sensibili.

Innovazione e Impatto del Multi-Modal Discussion Transformer

“Ci auguriamo davvero che questa tecnologia possa contribuire a ridurre il costo emotivo del dover setacciare manualmente il linguaggio d’odio,” ha affermato Liam Hebert, uno studente di dottorato in informatica a Waterloo e primo autore dello studio. “Crediamo che adottando un approccio centrato sulla comunità nelle nostre applicazioni di IA, possiamo aiutare a creare spazi online più sicuri per tutti.”

I ricercatori hanno costruito modelli per analizzare il significato delle conversazioni umane per molti anni, ma questi modelli hanno storicamente avuto difficoltà a comprendere conversazioni sfumate o dichiarazioni contestuali. I modelli precedenti potevano identificare il linguaggio d’odio con un’accuratezza massima del 74%, inferiore a quanto raggiunto dalla ricerca di Waterloo.

Importanza del Contesto nel Rilevamento del Linguaggio d’Odio

“Il contesto è molto importante per comprendere il linguaggio d’odio,” ha detto Hebert. “Ad esempio, il commento ‘È disgustoso!’ potrebbe essere innocuo di per sé, ma il suo significato cambia drasticamente se è in risposta a una foto di pizza con ananas rispetto a una persona di un gruppo emarginato.

“Capire quella distinzione è facile per gli umani, ma addestrare un modello a comprendere le connessioni contestuali in una discussione, includendo elementi multimediali come immagini, è in realtà un problema molto difficile.”

Dataset e Addestramento del Modello

A differenza degli sforzi precedenti, il team di Waterloo ha costruito e addestrato il loro modello su un dataset composto non solo da commenti odiosi isolati, ma anche dal contesto di quei commenti. Il modello è stato addestrato su 8.266 discussioni di Reddit con 18.359 commenti etichettati provenienti da 850 comunità.

“Più di tre miliardi di persone usano i social media ogni giorno,” ha detto Hebert. “L’impatto di queste piattaforme social ha raggiunto livelli senza precedenti. C’è un enorme bisogno di rilevare il linguaggio d’odio su larga scala per costruire spazi dove tutti siano rispettati e al sicuro.”

La ricerca, intitolata Multi-Modal Discussion Transformer: Integrating Text, Images and Graph Transformers to Detect Hate Speech on Social Media, è stata recentemente pubblicata negli atti della Trentaottava Conferenza AAAI sull’Intelligenza Artificiale.