Intelligenza Artificiale

OpenAI aiuta a scoprire immagini ed audio AI

Tempo di lettura: 2 minuti. Scopri come OpenAI sta avanzando nella tecnologia di rilevamento delle immagini e nel watermarking audio per garantire la trasparenza

OpenAI ha annunciato l’introduzione di nuovi strumenti per rilevare se immagini o tracce audio sono state generate dalla sua Intelligenza artificiale, DALL-E, e ha introdotto nuovi metodi di watermarking per contrassegnare più chiaramente i contenuti generati dall’IA.

Dettagli degli strumenti

Classificatore di Immagini: OpenAI ha sviluppato un classificatore che utilizza l’IA per determinare se una foto è stata generata dall’IA. Questo strumento predice la probabilità che un’immagine sia stata creata da DALL-E 3 con una precisione del 98%, anche se l’immagine è stata ritagliata, compressa o modificata nella saturazione.

Watermarking Audio: Insieme al classificatore, OpenAI ha introdotto un watermark resistente alle manomissioni che può etichettare contenuti audio con segnali invisibili. Questo è particolarmente utile per tracciare l’autenticità dei contenuti audio generati.

Prestazioni e Limitazioni: Mentre il classificatore funziona bene con le immagini generate da DALL-E 3, la sua efficacia nel rilevare immagini prodotte da altri modelli di IA è inferiore, riuscendo a identificare solo tra il 5 e il 10% delle immagini generate da altre piattaforme come Midjourney.

Implementazione di Watermarking

OpenAI ha già implementato i “content credentials” nei metadati delle immagini attraverso la Coalition of Content Provenance and Authority (C2PA), di cui fanno parte anche Microsoft e Adobe. Questo mese, OpenAI si è anche unita al comitato direttivo della C2PA, rafforzando il suo impegno nel fornire trasparenza sulla provenienza dei contenuti AI.

Progetti Futuri e Feedback: I nuovi watermark audio sono già stati aggiunti ai clip prodotti da Voice Engine, la piattaforma di sintesi vocale di OpenAI. Tuttavia, sia il classificatore di immagini sia il watermarking audio sono ancora in fase di perfezionamento e OpenAI sta cercando feedback dagli utenti per testarne l’efficacia.

Contesto Storico: OpenAI ha una lunga storia nello sviluppo di strumenti per il rilevamento di contenuti generati dall’IA, sebbene nel 2023 abbia terminato un programma per l’identificazione di testi scritti dall’IA a causa della bassa accuratezza del classificatore di testi.

Implicazioni

Questi sviluppi non solo aiutano a mantenere l’integrità e la trasparenza nell’uso delle tecnologie di generazione di contenuti IA, immagini ed audio, ma forniscono anche strumenti essenziali per gli utenti e i creatori di contenuti per verificare l’autenticità e la provenienza dei materiali che consumano o producono. Questi strumenti rappresentano un passo significativo verso un maggiore controllo e comprensione dei contenuti generati dall’IA, cruciali in un’era dove la distinzione tra contenuto reale e sintetico diventa sempre più sfumata.

Intelligenza Artificiale

Psicologia delle macchine: un ponte verso l’AGI

Tempo di lettura: 2 minuti. La psicologia delle macchine potrebbe essere la chiave per l’intelligenza artificiale generale. Scopri come AGI rivoluzionerà la società nei prossimi anni.

L’intelligenza artificiale generale (AGI), da tempo considerata il “Sacro Graal” della ricerca sull’intelligenza artificiale, sembra essere più vicina che mai. Secondo Robert Johansson, ricercatore e psicologo presso l’Università di Linköping, l’AGI potrebbe diventare una realtà nei prossimi cinque anni, con un potenziale impatto significativo sulla società.

Un approccio basato su principi psicologici

La strada verso l’AGI è tutt’altro che semplice. Mentre alcuni ricercatori puntano sui modelli linguistici su larga scala, come ChatGPT, altri esplorano simulazioni cerebrali. Johansson propone un approccio interdisciplinare, chiamato psicologia delle macchine, che combina principi di apprendimento psicologico con sistemi logici avanzati.

Il suo lavoro utilizza il sistema di ragionamento non-assiomatico (NARS), progettato per operare con dati incompleti, potenza computazionale limitata e in tempo reale. Questo sistema, integrato con i principi della psicologia dell’apprendimento, mira a replicare la capacità umana di apprendere dall’esperienza e applicare tale apprendimento a nuove situazioni.

L’importanza della psicologia nell’AGI

Johansson sottolinea che la psicologia potrebbe diventare una scienza cruciale per sviluppare un’intelligenza artificiale a livello umano. Gli esseri umani, già a 18 mesi, iniziano ad applicare le loro esperienze a molteplici contesti, una capacità che distingue la nostra intelligenza da quella di altre specie.

Se questa capacità potesse essere implementata in un computer, Johansson ritiene che si potrebbe risolvere l’enigma dell’intelligenza artificiale su scala umana. Tuttavia, il raggiungimento dell’AGI pone anche sfide etiche e legali, come il riconoscimento dei diritti e delle responsabilità di questi agenti artificiali.

Un futuro promettente e sfide da affrontare

La possibilità di un’AGI in grado di agire come psicologi virtuali, ricercatori o persino di contribuire all’evoluzione morale dell’umanità è affascinante. Tuttavia, Johansson avverte che questa tecnologia va gestita con attenzione per evitare usi dannosi, come la creazione di divisioni sociali.

La psicologia delle macchine, un campo emergente che collega psicologia e informatica, rappresenta un passo cruciale verso la realizzazione dell’AGI. Mentre ci avviciniamo a questa svolta, rimane fondamentale considerare gli impatti etici, legali e sociali di un’intelligenza artificiale che potrebbe cambiare radicalmente il nostro modo di vivere e interagire.

Intelligenza Artificiale

Neurone artificiale basato su laser: futuro AI e calcolo avanzato

Tempo di lettura: 2 minuti. Laser neuron-based: neurone artificiale a laser con velocità 10 GBaud per avanzamenti in intelligenza artificiale e calcolo ultrarapido.

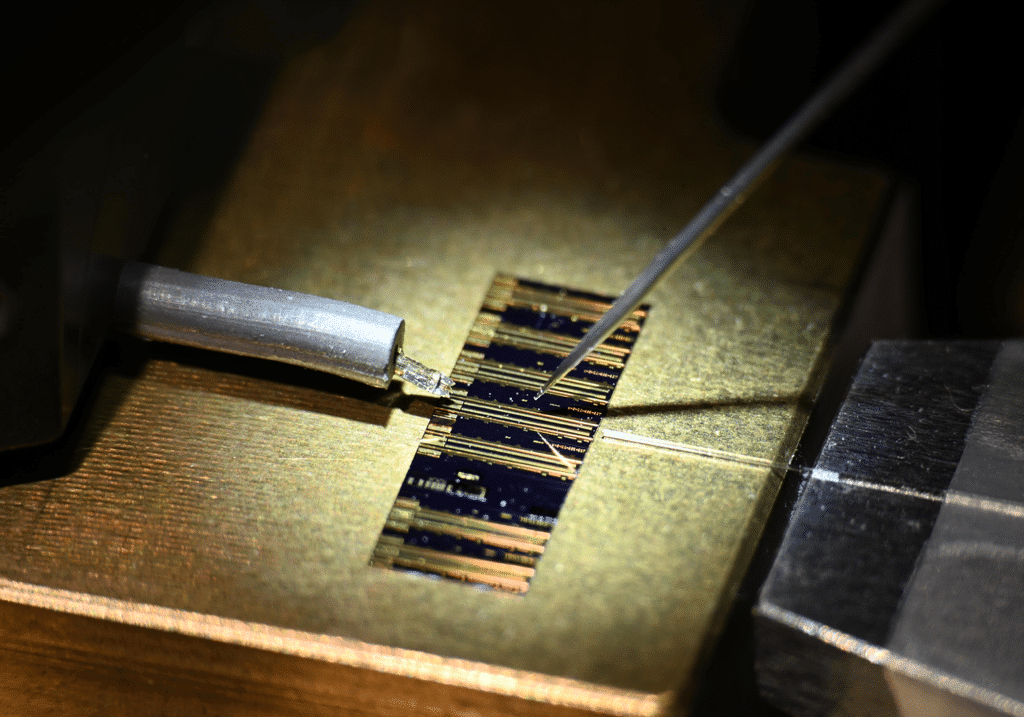

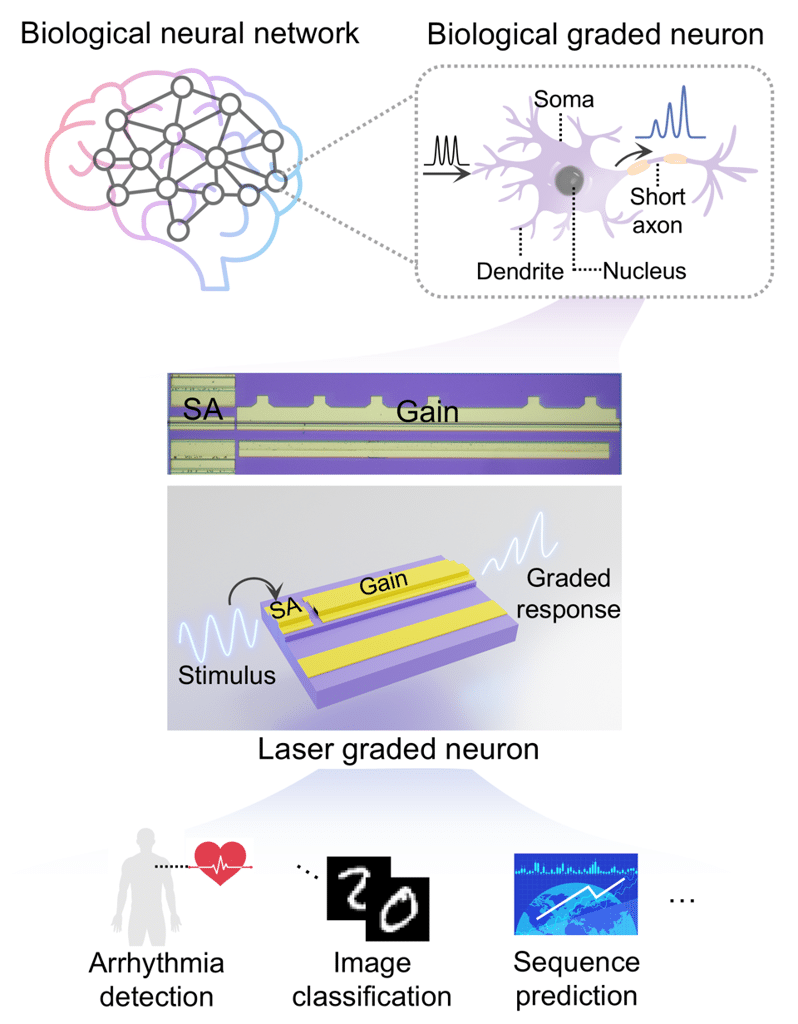

Un team di ricercatori della Chinese University of Hong Kong ha sviluppato un neurone artificiale basato su laser che replica il comportamento dei neuroni biologici con una velocità di elaborazione straordinaria: fino a 10 GBaud, un miliardo di volte più veloce dei neuroni umani. Questa tecnologia promette applicazioni rivoluzionarie nell’ambito dell’intelligenza artificiale e dell’elaborazione dei dati in tempo reale.

Cosa rende unico il laser neuron-based?

I neuroni biologici, come quelli graduati, elaborano informazioni attraverso variazioni continue del potenziale di membrana. I ricercatori hanno emulato questa capacità in un dispositivo a laser quantum-dot, superando i limiti di velocità dei neuroni artificiali fotonici tradizionali.

Mentre i neuroni fotonici spiking si basano su impulsi discreti, spesso soggetti a ritardi e perdita di informazioni, il laser graded neuron utilizza segnali radiofrequenza iniettati nella sezione di assorbimento del laser. Questo approccio riduce i tempi di risposta, eliminando la necessità di sorgenti laser aggiuntive e modulatori, con conseguenti vantaggi in termini di semplicità ed efficienza energetica.

Applicazioni nel campo dell’AI e del calcolo avanzato

Il laser neuron-based è stato impiegato per costruire un sistema di reservoir computing, ideale per elaborare dati temporali come riconoscimento vocale, previsioni meteorologiche e analisi mediche. Durante i test, il sistema ha elaborato 100 milioni di segnali cardiaci al secondo, identificando anomalie come aritmie con un’accuratezza del 98,4%.

Il dispositivo ha anche dimostrato eccellenti capacità nel riconoscimento di pattern e nella previsione di sequenze a lungo termine, elaborando 34,7 milioni di immagini digitali scritte a mano in un solo secondo.

Prospettive future e innovazioni

I ricercatori prevedono di aumentare ulteriormente la velocità di elaborazione e di sviluppare reti più complesse combinando più neuroni laser in una struttura simile ai neuroni biologici. Questo potrebbe portare a una nuova generazione di sistemi di calcolo ultrarapidi per applicazioni in ambiti critici come:

- Diagnostica medica avanzata.

- Veicoli autonomi.

- Automazione industriale e robotica.

Con il neurone artificiale basato su laser, la tecnologia si avvicina sempre più alla replicazione delle funzioni cognitive umane, con applicazioni che potrebbero rivoluzionare il calcolo e l’intelligenza artificiale. Questo sviluppo rappresenta un passo avanti significativo verso sistemi più veloci, intelligenti e sostenibili, capaci di affrontare sfide globali in settori critici.

Intelligenza Artificiale

ChatGpt: OpenAI sanzione di 15 milioni da Garante Privacy

Tempo di lettura: 2 minuti. OpenAI dovrà realizzare una campagna informativa di sei mesi e pagare una sanzione di 15 milioni di euro: è il risultato dopo un anno

Il Garante per la protezione dei dati personali ha adottato nei giorni scorsi un provvedimento correttivo ed una relativa sanzione nei confronti di OpenAI in relazione alla gestione del servizio ChatGPT.

Il provvedimento, che accerta le violazioni a suo tempo contestate alla società californiana, arriva all’esito di un’istruttoria avviata nel marzo del 2023 e dopo che l’EDPB (Comitato europeo per la protezione dei dati) ha pubblicato il parere con il quale identifica un approccio comune ad alcune delle più rilevanti questioni relative al trattamento dei dati personali nel contesto della progettazione, sviluppo e distribuzione di servizi basati sull’intelligenza artificiale.

Secondo il Garante la società statunitense, che ha creato e gestisce il chatbot di intelligenza artificiale generativa, oltre a non aver notificato all’Autorità la violazione dei dati subita nel marzo 2023, ha trattato i dati personali degli utenti per addestrare ChatGPT senza aver prima individuato un’adeguata base giuridica e ha violato il principio di trasparenza e i relativi obblighi informativi nei confronti degli utenti. Per di più, OpenAI non ha previsto meccanismi per la verifica dell’età, con il conseguente rischio di esporre i minori di 13 anni a risposte inidonee rispetto al loro grado di sviluppo e autoconsapevolezza.

L’Autorità, con l’obiettivo di garantire innanzitutto un’effettiva trasparenza del trattamento dei dati personali, ha ordinato a OpenAI – utilizzando per la prima volta i nuovi poteri previsti dall’articolo 166 comma 7 del Codice Privacy – di realizzare una campagna di comunicazione istituzionale di 6 mesi su radio, televisione, giornali e Internet.

I contenuti, da concordare con l’Autorità, dovranno promuovere la comprensione e la consapevolezza del pubblico sul funzionamento di ChatGPT, in particolare sulla raccolta dei dati di utenti e non-utenti per l’addestramento dell’intelligenza artificiale generativa e i diritti esercitabili dagli interessati, inclusi quelli di opposizione, rettifica e cancellazione.

Grazie a tale campagna di comunicazione, gli utenti e i non-utenti di ChatGPT dovranno essere sensibilizzati su come opporsi all’addestramento dell’intelligenza artificiale generativa con i propri dati personali e, quindi, essere effettivamente posti nelle condizioni di esercitare i propri diritti ai sensi del GDPR.

Il Garante ha comminato a OpenAI una sanzione di quindici milioni di euro calcolata anche tenendo conto dell’atteggiamento collaborativo della società.

Infine, tenuto conto che la società, nel corso dell’istruttoria, ha stabilito in Irlanda il proprio quartier generale europeo, il Garante – in ottemperanza alla regola del c.d. one stop shop – ha trasmesso gli atti del procedimento all’Autorità di protezione dati irlandese (DPC), divenuta autorità di controllo capofila ai sensi del GDPR, affinché prosegua l’istruttoria in relazione a eventuali violazioni di natura continuativa non esauritesi prima dell’apertura dello stabilimento europeo.

-

Economia3 giorni ago

Economia3 giorni agoSanzioni per violazioni del GDPR per Meta e Netflix

-

Sicurezza Informatica1 giorno ago

Sicurezza Informatica1 giorno agoMinacce npm, firewall Sophos e spyware su Android

-

Sicurezza Informatica3 giorni ago

Sicurezza Informatica3 giorni agoNodeStealer e phishing via Google Calendar: nuove minacce

-

Sicurezza Informatica4 giorni ago

Sicurezza Informatica4 giorni agoWindows, rischi Visual Studio Code, file MSC e kernel

-

Sicurezza Informatica4 giorni ago

Sicurezza Informatica4 giorni agoHubPhish, targeting politico e vulnerabilità critiche

-

Sicurezza Informatica4 giorni ago

Sicurezza Informatica4 giorni agoNvidia, SonicWall e Apache Struts: vulnerabilità critiche e soluzioni

-

Sicurezza Informatica1 settimana ago

Sicurezza Informatica1 settimana agoBadBox su IoT, Telegram e Viber: Germania e Russia rischiano

-

Sicurezza Informatica1 settimana ago

Sicurezza Informatica1 settimana agoPUMAKIT: analisi del RootKit malware Linux