L’intelligenza artificiale viene spesso presentata come una tecnologia capace di ragionare in modo simile a un essere umano. Ma cosa accade quando due dei più avanzati modelli di ragionamento vengono messi alla prova in una partita di scacchi?

Questa è la domanda che si è posto Giuseppe Gullo, CEO e Founder di ProfessionAI, esperto di intelligenza artificiale dal 2014. Per rispondere, ha organizzato una sfida tra OpenAI o1 e DeepSeek R1, con l’obiettivo di testare la loro capacità di pianificare strategie e di prendere decisioni in uno scenario che richiede logica e previsione.

I risultati hanno mostrato limiti evidenti, mettendo in discussione la reale capacità di ragionamento di questi modelli.

L’idea dell’esperimento

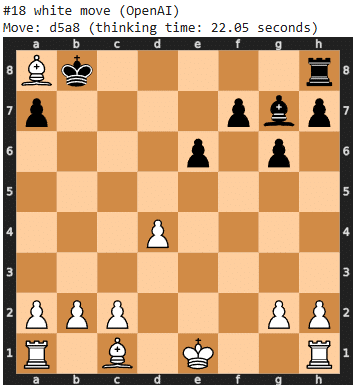

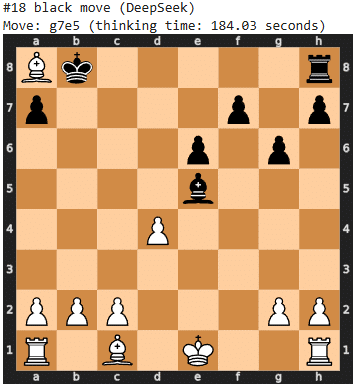

Un modello di intelligenza artificiale dovrebbe teoricamente essere in grado di giocare a scacchi, almeno a livello base. Le regole del gioco sono ben definite e i dataset di addestramento contengono numerosi riferimenti al gioco. L’esperimento di Giuseppe Gullo ha messo alla prova questa teoria facendo giocare OpenAI o1 contro DeepSeek R1 e monitorando diversi parametri, tra cui la qualità delle mosse, il tempo di ragionamento e la capacità di evitare errori.

Il test si è basato su più partite, in cui ogni modello ha giocato sia con i pezzi bianchi che con quelli neri. I risultati sono stati raccolti per identificare differenze di approccio e punti di forza o debolezza di ciascun modello.

Differenze di comportamento tra OpenAI e DeepSeek

Dopo numerose partite, è emerso che OpenAI o1 e DeepSeek R1 adottano strategie di gioco molto diverse.

- OpenAI o1 tende a giocare in modo più dinamico e creativo, ma commette numerosi errori, inclusi movimenti illegali e scelte strategicamente errate. In alcune partite, ha addirittura ignorato opportunità di scacco matto, scegliendo invece mosse che hanno compromesso la sua posizione.

- DeepSeek R1 ha dimostrato maggiore rigore nel rispetto delle regole e non ha mai commesso errori evidenti, ma il suo stile di gioco è apparso eccessivamente difensivo. Ha mostrato difficoltà nel costruire attacchi efficaci e ha evitato di prendere rischi anche quando la posizione sulla scacchiera lo avrebbe permesso.

Analisi dei dati raccolti

Dai dati raccolti, emergono differenze significative nei tempi di ragionamento e nella precisione delle mosse. DeepSeek R1 ha un tempo medio di ragionamento superiore, segno che impiega più tempo per valutare la posizione, ma non ha mai generato mosse illegali. OpenAI o1 è più veloce nel prendere decisioni, ma ha dimostrato una propensione maggiore a compiere errori.

Tabella comparativa delle prestazioni

| Modello | Tempo medio di ragionamento | Mosse illegali | Costo per partita |

|---|---|---|---|

| DeepSeek R1 | 182 sec (min 48, max 431) | 0 | $0.11 |

| OpenAI o1 | 30 sec (min 9, max 53) | Diverse | $2.08 |

Questi dati evidenziano che DeepSeek R1 è più affidabile ma meno aggressivo, mentre OpenAI o1 gioca in modo più imprevedibile e rischioso.

Perché i modelli di ragionamento falliscono negli scacchi?

L’esperimento di Giuseppe Gullo dimostra che i modelli di linguaggio non possiedono una reale capacità di ragionamento strategico. La loro modalità operativa si basa sull’analisi di pattern statistici e sulla generazione di risposte coerenti con i dati di addestramento, ma non sul ragionamento logico nel senso umano del termine.

Questi modelli non analizzano la posizione sulla scacchiera come farebbe un motore specializzato come Stockfish. Non valutano concretamente il valore di una mossa in funzione degli sviluppi successivi, ma si limitano a prevedere quale potrebbe essere la mossa più probabile in un determinato contesto, basandosi sulle informazioni presenti nei loro dataset.

Implicazioni per il futuro dell’intelligenza artificiale

L’esperimento suggerisce che gli attuali modelli di ragionamento, pur essendo capaci di simulare un processo decisionale, non possiedono ancora una vera comprensione strategica. Questo implica che il progresso verso una vera intelligenza artificiale generale (AGI) richiederà soluzioni più avanzate, che integrino la capacità di elaborare informazioni linguistiche con un approccio simbolico e logico più sofisticato.

L’integrazione di tecnologie come le reti neurali specializzate potrebbe rappresentare un passo avanti, consentendo ai modelli di combinare riconoscimento del linguaggio con un’analisi più approfondita dei dati.

L’esperimento di Giuseppe Gullo dimostra che gli attuali modelli di ragionamento non sono ancora in grado di competere con motori di scacchi specializzati o con giocatori umani esperti. Pur essendo in grado di generare mosse valide nella maggior parte dei casi, il loro approccio al gioco è limitato dalla natura statistica del loro funzionamento.

Per ora, la capacità di ragionamento delle intelligenze artificiali rimane confinata a contesti in cui la previsione statistica è sufficiente. Il raggiungimento di un’intelligenza artificiale veramente strategica richiederà innovazioni che vadano oltre l’attuale architettura dei modelli linguistici.