Sommario

Il U.K. Safety Institute, un ente britannico dedicato alla sicurezza dell’intelligenza artificiale, ha lanciato “Inspect”, una suite di strumenti progettata per rafforzare la sicurezza delle applicazioni AI. Questo toolkit, rilasciato sotto licenza open source (MIT License), permette a industria, organizzazioni di ricerca e istituzioni accademiche di sviluppare e eseguire valutazioni sui modelli di IA.

Funzionalità di Inspect

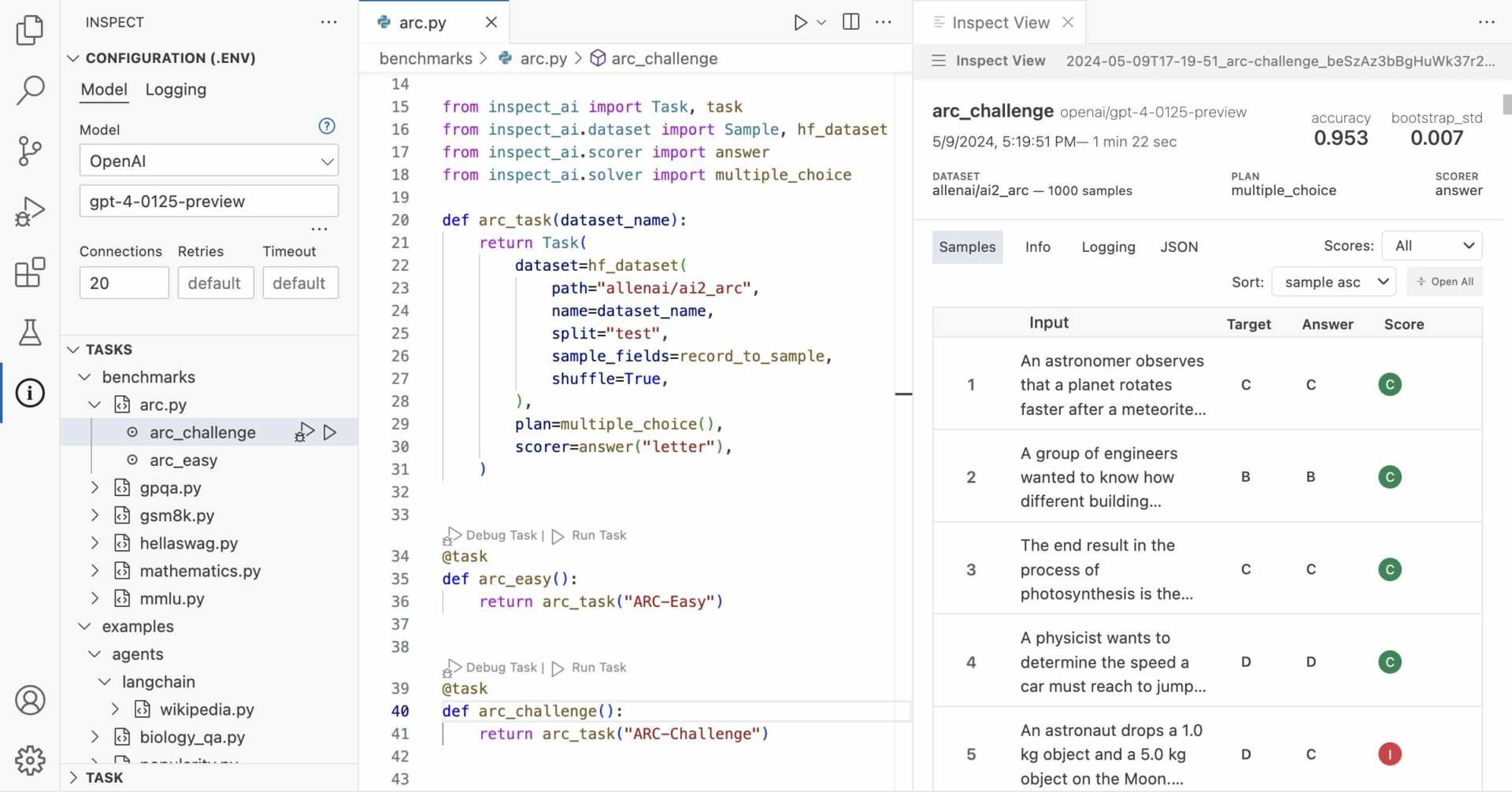

Inspect mira a valutare alcune capacità fondamentali dei modelli AI, come la conoscenza di base e la capacità di ragionamento, generando un punteggio basato sui risultati. La piattaforma si compone di tre componenti principali: data sets, solvers e scorers. I data sets forniscono campioni per i test di valutazione, i solvers eseguono i test e gli scorers valutano il lavoro dei solvers aggregando i punteggi in metriche.

Estendibilità e collaborazione

Un punto di forza di Inspect è la sua estendibilità. I componenti integrati possono essere potenziati tramite pacchetti di terze parti scritti in Python, permettendo agli utenti di adattare e ampliare la piattaforma in base alle proprie esigenze specifiche. Questa flessibilità promuove una collaborazione aperta e la condivisione di approcci per le valutazioni della sicurezza AI.

Supporto e potenziale impatto

Ian Hogarth, presidente del Safety Institute, ha evidenziato l’importanza di un approccio condiviso e accessibile alle valutazioni di sicurezza AI, sperando che Inspect possa servire come un fondamento su cui la comunità globale di AI può costruire. La piattaforma ha già suscitato interesse da parte di esperti e aziende del settore, con proposte di integrazione con altre librerie di modelli o la creazione di classifiche pubbliche basate sui risultati delle valutazioni di Inspect.

Contesto e sviluppi futuri

Il lancio di Inspect segue iniziative simili negli Stati Uniti, come il programma NIST GenAI, e rientra in un più ampio partenariato transatlantico per sviluppare metodi avanzati di test dei modelli di AI annunciato dai governi degli USA e del Regno Unito. Questa collaborazione mira a valutare i rischi associati all’IA e all’IA generativa, spingendo verso uno sviluppo più sicuro e responsabile delle tecnologie AI.

Con Inspect, U.K. Safety Institute non solo fornisce uno strumento vitale per la verifica della sicurezza dei modelli di IA, ma facilita anche un ecosistema di cooperazione e miglioramento continuo nel campo della sicurezza AI, ponendo le basi per futuri sviluppi normativi e tecnologici.