Intelligenza Artificiale

L’Unione Europea manca gli obiettivi sull’Intelligenza Artificiale

Tempo di lettura: 3 minuti. Il rapporto della Corte dei Conti Europea critica la strategia dell’UE per l’IA, evidenziando ritardi e mancanza di coordinazione che hanno portato a una spesa inferiore agli obiettivi prefissati.

Secondo un recente rapporto della Corte dei Conti Europea (ECA), l’Unione Europea ha mancato gli obiettivi prefissati per l’intelligenza artificiale (IA) a causa dei ritardi nell’avvio del programma Horizon Europe nel 2021. La mancanza di fondi si è tradotta in un deficit di spesa di 600 milioni di euro per i progetti di IA.

Critiche e problemi di coordinazione

Il rapporto della ECA evidenzia diverse criticità, tra cui la mancanza di controlli sui progetti una volta terminati, la frammentazione delle responsabilità tra numerosi dipartimenti e agenzie, e l’assenza di una panoramica accurata dei progetti finanziati. Mihails Kozlovs, membro della ECA, ha dichiarato: “È preoccupante che, a più di cinque anni dall’adozione del piano UE per l’IA, debolezze nell’implementazione e nel monitoraggio delle prestazioni mostrano la necessità di un maggiore focus della Commissione nel conseguire risultati.”

La Commissione Europea ha difeso il proprio operato, respingendo un numero insolitamente alto di proposte avanzate dalla ECA nel rapporto. Tuttavia, l’intervento della Corte dei Conti arriva in un momento cruciale, poiché l’UE continua a inseguire Stati Uniti e Cina in un settore considerato chiave per la crescita economica e la sicurezza.

Confronto con Stati Uniti e Cina

I dati dell’Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE) mostrano che nel 2022 gli Stati Uniti hanno investito 55 miliardi di euro in capitale di rischio per l’IA, la Cina 18 miliardi e l’UE solo 8 miliardi, un calo significativo rispetto all’anno precedente. L’UE, pur mantenendo una forte posizione nella ricerca sull’IA, è rimasta indietro in termini di brevetti e investimenti privati.

Ritardi e mancanza di Coordinamento

Il rapporto della ECA copre il periodo dal 2018, anno in cui i governi europei hanno iniziato a rilasciare numerosi piani per l’IA. La Commissione ha creato il proprio piano per l’IA nello stesso anno, aggiornandolo nel 2021. Parte della strategia era investire nella ricerca e sviluppo dell’IA attraverso i programmi Horizon 2020 e Horizon Europe.

Nonostante la Commissione abbia quasi raggiunto l’obiettivo di spesa di 1,5 miliardi di euro nel periodo 2018-2020, è rimasta 600 milioni di euro sotto l’obiettivo di 2 miliardi per il 2021-2022 a causa dei ritardi nell’adozione di Horizon Europe, che è la principale fonte di finanziamento per i progetti di IA nell’UE.

Problemi di implementazione

Il rapporto della ECA ha sottolineato che non esiste un organo o comitato dell’UE incaricato di coordinare i progetti nelle fasi di pianificazione, implementazione o valutazione. Ciò ha portato a progetti sovrapposti e a una gestione frammentata dei finanziamenti per l’IA. Ad esempio, l’UE ha finanziato tre diversi progetti di tassonomia per l’IA attraverso Horizon 2020, l’Istituto Europeo di Innovazione e Tecnologia (EIT) e il Centro Comune di Ricerca, senza alcuna coordinazione tra loro.

Risposta della Commissione

In risposta al rapporto della ECA, la Commissione ha difeso il proprio record sull’IA, sottolineando la creazione di un nuovo Ufficio Europeo per l’IA, che aiuterà ad applicare il nuovo AI Act dell’UE. La Commissione ha anche evidenziato che dal 2021 il Consiglio Europeo per l’Innovazione ha erogato 440 milioni di euro in sovvenzioni e investimenti alle aziende che sviluppano o implementano l’IA.

La Commissione ha accettato diverse raccomandazioni della ECA, come l’aggiornamento degli obiettivi di investimento nell’IA alla luce del boom dell’IA generativa. Tuttavia, ha rifiutato la richiesta di creare un quadro per il migliore tagging e il monitoraggio del supporto finanziario per l’IA, sostenendo che sarebbe troppo costoso e oneroso.

Il rapporto della Corte dei Conti Europea mette in luce le sfide che l’UE deve affrontare per raggiungere i propri obiettivi sull’intelligenza artificiale. Sebbene siano stati compiuti progressi, la mancanza di coordinazione e i ritardi nell’implementazione dei programmi di finanziamento hanno limitato l’impatto degli investimenti. Per recuperare il ritardo rispetto a Stati Uniti e Cina, l’UE dovrà migliorare il coordinamento e l’efficacia delle proprie strategie di investimento nell’IA.

Intelligenza Artificiale

L’intelligenza artificiale: strumenti e trattamenti personalizzati in medicina

Tempo di lettura: 2 minuti. L’intelligenza artificiale trasforma la sanità con il Reinforcement Learning e le QuantNets. Strumenti innovativi per trattamenti personalizzati e analisi avanzate.

La ricerca nel campo dell’intelligenza artificiale (AI) continua a progredire, offrendo soluzioni innovative per la gestione delle cure mediche. Gli studi condotti dalla Weill Cornell Medicine e dalla Rockefeller University esplorano l’uso del Reinforcement Learning (RL) per ottimizzare strategie terapeutiche e di nuove reti neurali adattate per dati strutturati come grafi, aprendo la strada a cure personalizzate.

Reinforcement Learning per la gestione di patologie croniche e psichiatriche

Il Reinforcement Learning è una branca dell’AI che consente a modelli di apprendere decisioni ottimali basate su feedback. Utilizzato per eccellere in giochi come scacchi e Go, il RL potrebbe rivoluzionare il trattamento di malattie croniche e psichiatriche, adattandosi in tempo reale alle condizioni dei pazienti e ai risultati delle cure.

Uno studio recente ha introdotto Episodes of Care (EpiCare), il primo benchmark di RL specifico per la sanità. Testando cinque modelli di RL avanzati, i ricercatori hanno dimostrato che, pur superando i metodi standard di cura, questi modelli richiedono enormi quantità di dati simulati per funzionare, rendendo complesso il loro utilizzo nella pratica clinica. Inoltre, strumenti di valutazione basati su dati storici, come gli Off-Policy Evaluation (OPE), si sono dimostrati inaccurati in scenari sanitari reali.

Dr. Logan Grosenick, che ha guidato lo studio, ha sottolineato l’importanza di EpiCare per sviluppare modelli più affidabili e adattabili alla medicina. Migliorare questi strumenti rappresenta un passo cruciale verso trattamenti personalizzati basati sull’AI.

Reti neurali per analisi di dati strutturati a grafo

In un altro studio presentato alla NeurIPS 2024, il team di Dr. Grosenick ha adattato le Convolutional Neural Networks (CNNs) per analizzare dati strutturati a grafo, come reti cerebrali o genetiche. Le CNN, già fondamentali per il riconoscimento delle immagini, sono state generalizzate per modellare graficamente connessioni complesse.

Questa tecnologia, denominata Quantized Graph Convolutional Networks (QuantNets), permette di analizzare i grafi rappresentati da nodi e collegamenti, come quelli tra regioni cerebrali durante il trattamento di depressione o disturbo ossessivo-compulsivo. Il modello è stato applicato a dati EEG con l’obiettivo di identificare dinamiche di connettività cerebrale, consentendo analisi più dettagliate e personalizzate del trattamento.

Le QuantNets hanno potenziale in diversi campi, dalla modellazione del comportamento animale al tracciamento delle espressioni facciali umane per analisi emotive.

Gli studi della Weill Cornell Medicine dimostrano come l’AI stia avvicinando la sanità a un modello più personalizzato. Sia il Reinforcement Learning per strategie terapeutiche che le reti QuantNets per analisi grafiche sono passi significativi verso cure innovative e adattabili. La ricerca continua a sviluppare strumenti affidabili, con l’obiettivo di migliorare la qualità della vita dei pazienti.

Intelligenza Artificiale

L’intelligenza artificiale interpreta lingua dei segni in tempo reale

Tempo di lettura: 2 minuti. L’AI interpreta la lingua dei segni americana con il 98% di accuratezza. Lo studio FAU utilizza MediaPipe e YOLOv8 per un sistema innovativo e accessibile.

Un team di ricercatori della Florida Atlantic University (FAU) ha sviluppato un sistema basato su intelligenza artificiale (AI) in grado di riconoscere con precisione i gesti della lingua dei segni americana (ASL) in tempo reale. Questa innovazione sfrutta tecniche avanzate di computer vision e modelli di deep learning, offrendo una soluzione tecnologica per migliorare la comunicazione tra persone sorde o con difficoltà uditive e il mondo circostante.

L’approccio tecnico: MediaPipe e YOLOv8

Lo studio si concentra sul riconoscimento delle lettere dell’alfabeto ASL utilizzando un dataset personalizzato composto da 29.820 immagini statiche di gesti della mano. Ogni immagine è stata annotata con 21 punti chiave (landmark) usando MediaPipe, un framework di Google dedicato al tracciamento dei movimenti corporei. Questa annotazione dettagliata ha fornito una rappresentazione spaziale accurata della struttura e della posizione della mano.

Questi dati sono stati utilizzati per addestrare YOLOv8, uno dei modelli di deep learning più avanzati per il rilevamento di oggetti, ottimizzando il processo di riconoscimento e classificazione dei gesti.

Bader Alsharif, primo autore della ricerca e candidato al dottorato presso il Dipartimento di Ingegneria Elettrica e Informatica della FAU, ha definito questa integrazione un “approccio innovativo mai esplorato prima, che apre nuove prospettive per applicazioni future.”

Prestazioni del modello e risultati

Il sistema sviluppato ha raggiunto risultati eccezionali, con:

- Accuratezza del 98%,

- Recall del 98%,

- F1 score del 99%,

- Media Average Precision (mAP) del 98%,

- mAP50-95 del 93%.

Questi numeri dimostrano l’efficacia del modello nel catturare anche le più piccole variazioni nei gesti, rendendolo affidabile e robusto in scenari reali.

Secondo Mohammad Ilyas, coautore dello studio e professore alla FAU, il successo è stato reso possibile dalla combinazione di transfer learning, creazione di dataset dettagliati e ottimizzazione dei parametri di apprendimento.

Applicazioni pratiche e prospettive future

Questo sistema ha il potenziale per essere utilizzato in applicazioni pratiche come strumenti di traduzione in tempo reale, migliorando l’accessibilità per la comunità sorda o con difficoltà uditive. Le potenziali aree di applicazione includono:

- Istruzione, per facilitare l’interazione tra studenti sordi e insegnanti.

- Sanità, per garantire una comunicazione più efficace tra pazienti e operatori sanitari.

- Settori sociali, per ridurre le barriere nella vita quotidiana.

Le future ricerche si concentreranno sull’espansione del dataset per includere un numero maggiore di gesti dinamici, migliorando ulteriormente l’accuratezza del modello. Inoltre, gli sforzi si orienteranno verso l’ottimizzazione per dispositivi edge, come smartphone o tablet, garantendo prestazioni in tempo reale anche in ambienti con risorse limitate.

Lo studio condotto dalla Florida Atlantic University rappresenta un importante passo avanti nella creazione di strumenti basati sull’intelligenza artificiale per la traduzione della lingua dei segni americana in tempo reale. Integrando tecnologie avanzate come MediaPipe e YOLOv8, i ricercatori hanno sviluppato un sistema altamente preciso e affidabile, che può migliorare significativamente l’accessibilità e l’inclusività per milioni di persone in tutto il mondo.

Intelligenza Artificiale

OpenAI sotto accusa: Elon Musk e Meta si schierano contro

Tempo di lettura: 3 minuti. Il caso OpenAI-Musk svela le tensioni sulla trasformazione da non-profit a for-profit. Rivelazioni su email e documenti approfondiscono il dibattito etico sull’intelligenza artificiale.

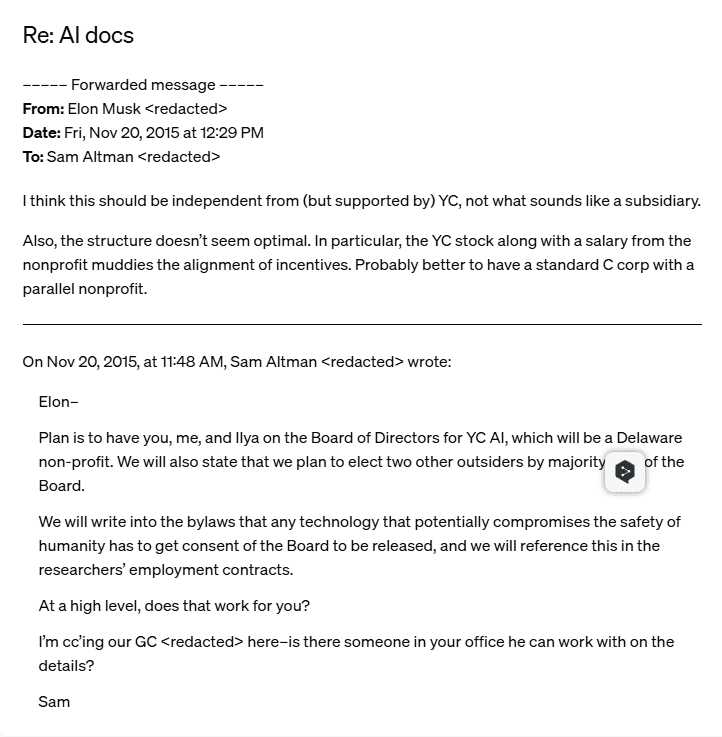

Le recenti rivelazioni di OpenAI gettano nuova luce sulle dinamiche interne che hanno portato alla sua trasformazione in azienda a scopo di lucro, e al ruolo controverso di Elon Musk in questa transizione. Attraverso la pubblicazione di email, documenti e comunicazioni interne, OpenAI ha svelato che Musk, inizialmente uno dei suoi principali sostenitori, aveva proposto cambiamenti strutturali che includessero una componente for-profit già prima della fondazione. Queste informazioni si inseriscono in un quadro legale e morale complesso, che coinvolge anche Microsoft e Meta, e sollevano interrogativi sul futuro dell’intelligenza artificiale e sulla trasparenza delle organizzazioni che la sviluppano.

Le accuse contro Elon Musk

Secondo i documenti rilasciati da OpenAI, Elon Musk avrebbe sostenuto sin dal principio la necessità di includere una struttura for-profit nella fondazione dell’organizzazione. Nel 2017, Musk propose un modello ibrido, con una parte non-profit che guidasse la ricerca e una componente for-profit destinata a capitalizzare i risultati economici. Tuttavia, questa visione includeva anche un elemento controverso: Musk voleva ottenere una quota di maggioranza e diventare il CEO della nuova entità.

Le sue proposte furono respinte dal consiglio di amministrazione di OpenAI, che considerava tale struttura incoerente con la missione originaria dell’organizzazione, focalizzata sull’interesse collettivo e sulla democratizzazione delle tecnologie AI. Musk, di fronte a questa opposizione, rassegnò le dimissioni nel febbraio 2018, sostenendo che il progetto non era più in linea con la sua visione.

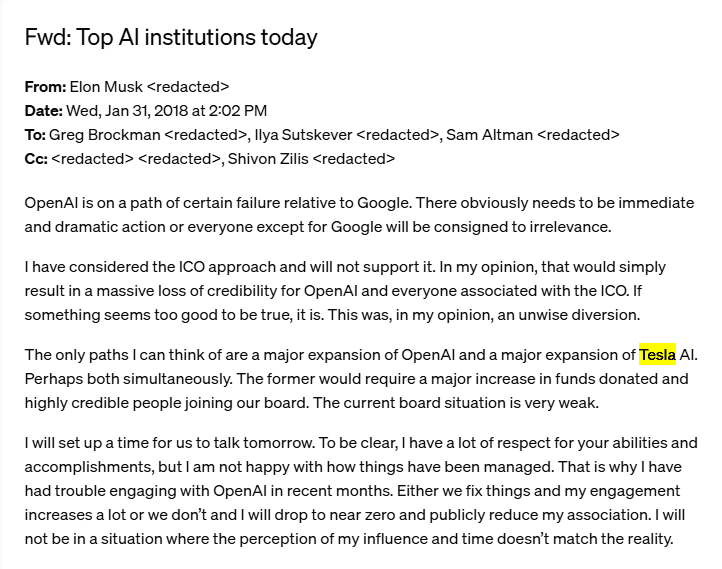

Musk e il piano di fusione con Tesla

Uno degli aspetti più sorprendenti emersi dalle comunicazioni interne riguarda la proposta di Elon Musk di fondere OpenAI con Tesla. Musk giustificò questa idea sostenendo che avrebbe garantito la sopravvivenza finanziaria dell’organizzazione e accelerato il suo sviluppo tecnologico, sfruttando le risorse di Tesla per implementare le tecnologie AI nei veicoli autonomi e in altri progetti.

Anche questa proposta fu respinta dal consiglio di amministrazione, che considerava il piano una minaccia per l’indipendenza di OpenAI. Musk, non riuscendo a ottenere il controllo strategico, si allontanò ulteriormente dall’organizzazione e iniziò a progettare la fondazione di una propria azienda di intelligenza artificiale, che sarebbe poi diventata xAI.

La trasformazione di OpenAI in azienda for-profit

Nonostante le dimissioni di Musk, OpenAI ha intrapreso nel 2019 il percorso verso una struttura for-profit, giustificando la decisione con la necessità di attrarre maggiori investimenti per competere con giganti come Google e Amazon. Questo passaggio ha visto l’ingresso di Microsoft come principale partner tecnologico e finanziario, con un accordo che ha garantito all’azienda di Redmond una posizione privilegiata nello sviluppo e nella distribuzione delle tecnologie OpenAI.

Musk ha fortemente criticato questa trasformazione, definendola un tradimento della missione originaria. Tuttavia, i documenti pubblicati da OpenAI sembrano indicare che lo stesso Musk aveva sostenuto in passato un modello simile, minando la credibilità delle sue accuse.

Le implicazioni legali e morali

Le accuse di Elon Musk contro OpenAI e Microsoft si sono tradotte in una battaglia legale che ha avuto molteplici sviluppi. Nel marzo 2023, Musk ha presentato una denuncia per violazione degli accordi contrattuali, sostenendo che l’organizzazione aveva abbandonato i suoi principi fondanti per perseguire profitti. Dopo una serie di ritiri e aggiornamenti delle accuse, Musk ha richiesto nel novembre 2024 un’ingiunzione per bloccare la transizione di OpenAI in azienda for-profit.

OpenAI, dal canto suo, ha respinto queste accuse, pubblicando prove che dimostrano come Musk stesso avesse spinto per un modello a scopo di lucro già nel 2017. L’azienda sostiene che le sue azioni sono in linea con gli obiettivi di sostenibilità e crescita, e che la partnership con Microsoft è stata fondamentale per garantire le risorse necessarie allo sviluppo delle tecnologie AI.

Il contesto etico e l’impatto sull’industria AI

Questo dibattito va oltre le questioni legali e solleva interrogativi più ampi sull’etica delle organizzazioni che sviluppano tecnologie avanzate. La trasformazione di OpenAI in azienda for-profit ha suscitato preoccupazioni nella comunità tecnologica, che teme una concentrazione del potere nelle mani di poche grandi aziende.

In questo contesto, anche Meta ha espresso il suo disappunto, sottolineando i rischi di creare un precedente che potrebbe incentivare altre organizzazioni non-profit a trasformarsi in aziende commerciali dopo aver ricevuto finanziamenti esentasse.

Il caso OpenAI-Musk mette in evidenza la complessità delle decisioni strategiche e le tensioni etiche nell’industria dell’intelligenza artificiale. Mentre OpenAI difende la necessità di attrarre investimenti per sviluppare tecnologie all’avanguardia, le accuse di Musk sollevano dubbi sull’integrità delle motivazioni alla base di queste scelte. Il futuro di OpenAI, e il suo ruolo nell’ecosistema AI globale, rimane un tema di dibattito acceso, con implicazioni che potrebbero ridefinire il rapporto tra innovazione, etica e profitto.

-

Smartphone1 settimana ago

Smartphone1 settimana agoRealme GT 7 Pro vs Motorola Edge 50 Ultra: quale scegliere?

-

Smartphone1 settimana ago

Smartphone1 settimana agoOnePlus 13 vs Google Pixel 9 Pro XL: scegliere o aspettare?

-

Smartphone1 settimana ago

Smartphone1 settimana agoSamsung Galaxy Z Flip 7: il debutto dell’Exynos 2500

-

Smartphone7 giorni ago

Smartphone7 giorni agoRedmi Note 14 Pro+ vs 13 Pro+: quale scegliere?

-

Sicurezza Informatica5 giorni ago

Sicurezza Informatica5 giorni agoBadBox su IoT, Telegram e Viber: Germania e Russia rischiano

-

Economia1 settimana ago

Economia1 settimana agoControversie e investimenti globali: Apple, Google e TikTok

-

Sicurezza Informatica13 ore ago

Sicurezza Informatica13 ore agoNvidia, SonicWall e Apache Struts: vulnerabilità critiche e soluzioni

-

Sicurezza Informatica1 settimana ago

Sicurezza Informatica1 settimana agoVulnerabilità cavi USB-C, Ivanti, WPForms e aggiornamenti Adobe