Meta ha annunciato una serie di importanti innovazioni all’Open Compute Project (OCP) Global Summit 2024, che riguardano l’infrastruttura aperta per l’intelligenza artificiale (AI) e le reti. Le novità includono una nuova piattaforma AI e una strategia di rete avanzata, con l’obiettivo di rendere l’hardware AI più efficiente e scalabile, aprendo la strada a soluzioni future per la comunità tech globale.

Meta e l’Open AI Hardware Vision: una piattaforma aperta per l’intelligenza artificiale

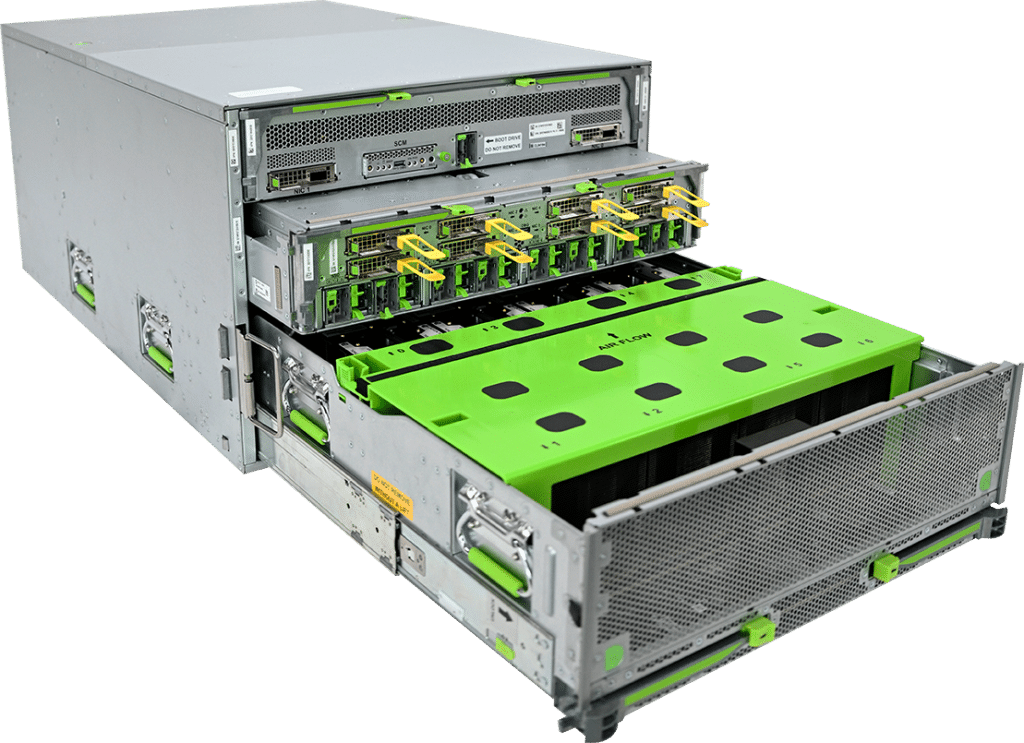

Al centro dell’approccio di Meta c’è il concetto di hardware aperto per AI, una visione che ha guidato la presentazione di nuove piattaforme e soluzioni al summit OCP 2024. Una delle innovazioni più rilevanti riguarda la piattaforma Catalina, un rack progettato per carichi di lavoro AI su larga scala, basato sulla piattaforma NVIDIA Blackwell e destinato a supportare GPU di nuova generazione come il chip NVIDIA GB200 Grace Blackwell. Questo rack non solo offre un’infrastruttura altamente modulare e flessibile, ma è anche in grado di supportare fino a 140kW di potenza, una capacità necessaria per alimentare le GPU che richiedono sempre più energia.

L’architettura aperta di Catalina consente alle aziende di personalizzare le configurazioni hardware in base alle esigenze dei propri carichi di lavoro AI, rendendolo un elemento chiave per la prossima generazione di modelli AI, tra cui Llama 3.1, il modello di linguaggio più avanzato di Meta. Questo modello, con 405 miliardi di parametri e una finestra di contesto di 128.000 token, ha richiesto un’infrastruttura di rete e calcolo senza precedenti, operando su cluster da 24.000 GPU NVIDIA H100. Meta prevede che la domanda di potenza di calcolo crescerà ulteriormente nei prossimi anni, e con soluzioni come Catalina e la crescente adozione di architetture aperte, la piattaforma è pronta a rispondere a queste sfide future.

Disaggregated Scheduled Fabric (DSF) e l’evoluzione delle reti per AI

Un altro punto centrale della presentazione di Meta riguarda l’innovazione nelle reti AI. La società ha introdotto il Disaggregated Scheduled Fabric (DSF), un’infrastruttura di rete aperta e disaggregata progettata per supportare i carichi di lavoro AI di prossima generazione. DSF consente la costruzione di reti ad alte prestazioni e scalabili, cruciali per i cluster AI che richiedono una larghezza di banda sempre maggiore.

Questa nuova architettura permette di evitare la congestione della rete in modo proattivo, migliorando l’efficienza generale delle reti e garantendo un flusso di dati costante tra le unità di accelerazione. La tecnologia DSF supporta interfacce RoCE Ethernet aperte, compatibili con vari acceleratori AI, inclusi i chip NVIDIA e AMD, oltre al Meta Training Inference Accelerator (MTIA), sviluppato internamente da Meta.

Il DSF si basa su switch foglia e spine distribuiti, con Meta che ha presentato nuove soluzioni hardware come lo switch foglia Arista 7700R4C e lo switch spine Arista 7720R4, entrambi basati su tecnologia Broadcom. Questi dispositivi supportano connessioni ad alta velocità fino a 800 Gbps, necessarie per le reti AI ad alte prestazioni. In parallelo, Meta ha annunciato i nuovi switch da 51 Tbps Minipack3 e Cisco 8501, sviluppati per reti ottiche 400G e 800G, ottimizzando l’efficienza energetica senza compromettere le prestazioni.

FBNIC e l’apertura del futuro delle reti AI

Meta ha inoltre annunciato il FBNIC, un modulo NIC multi-host progettato dalla società e basato sul primo ASIC per reti sviluppato da Meta. Il FBNIC supporta fino a quattro host con isolamento completo del percorso dati per ciascun host, migliorando così l’efficienza e la sicurezza delle comunicazioni tra i dispositivi.

Con il continuo sviluppo di ASIC personalizzati e il contributo alla comunità OCP, Meta conferma il suo impegno a creare un’infrastruttura aperta e collaborativa per AI. L’adozione di standard aperti e l’interoperabilità con tecnologie di vari fornitori garantiranno che le reti AI possano crescere in modo sostenibile, adattandosi alle crescenti esigenze di calcolo e comunicazione.

Un futuro aperto per l’infrastruttura AI

Le innovazioni presentate da Meta al summit OCP 2024 sottolineano l’importanza dell’apertura e della collaborazione nell’evoluzione delle infrastrutture AI. Con soluzioni come Catalina e DSF, Meta sta creando un ecosistema hardware scalabile e flessibile, che non solo supporta i carichi di lavoro AI di oggi, ma è pronto per affrontare le sfide di domani. L’impegno di Meta verso l’hardware aperto rappresenta un passo fondamentale per rendere l’intelligenza artificiale più accessibile e sostenibile, promuovendo l’innovazione su scala globale.