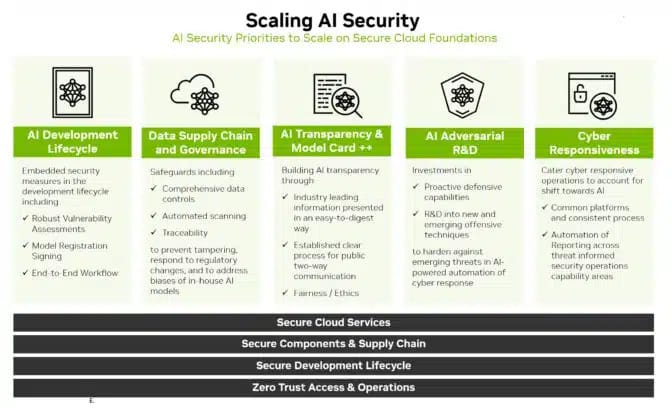

Nel contesto attuale, ogni azienda sta cercando di definire la propria strategia AI, sollevando immediatamente la questione della sicurezza. La buona notizia è che le politiche e le pratiche esistenti oggi offrono eccellenti punti di partenza. NVIDIA suggerisce un percorso che può essere riassunto in sei passaggi: espandere l’analisi delle minacce, ampliare i meccanismi di risposta, proteggere la catena di approvvigionamento dei dati, utilizzare l’IA per ampliare gli sforzi, essere trasparenti e creare miglioramenti continui.

Esplorare l’orizzonte espanso

Il primo passo è familiarizzare con il nuovo panorama. La sicurezza ora deve coprire l’intero ciclo di vita dello sviluppo AI, includendo nuove superfici di attacco come dati di addestramento, modelli e le persone e i processi che li utilizzano.

Ampliare le difese

Una volta chiaro il quadro delle minacce, è necessario definire modi per difendersi da esse. Monitorare attentamente le prestazioni del modello AI, assumendo che esso possa deviare, aprendo nuove superfici di attacco.

Estendere le salvaguardie esistenti

Proteggere i set di dati utilizzati per addestrare i modelli AI, che sono preziosi e vulnerabili. È importante stabilire un controllo di accesso per i dati di addestramento, proprio come per altri dati interni.

Ampliare la sicurezza con l’IA

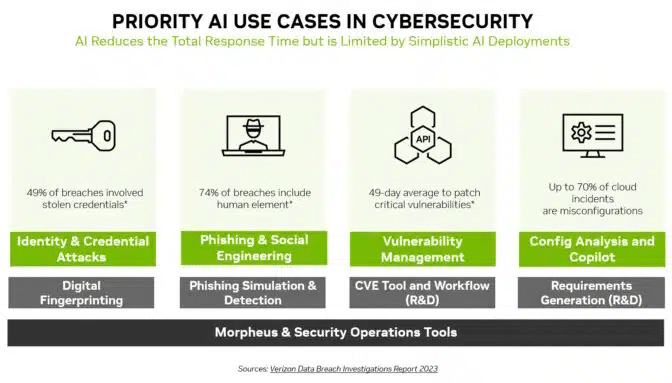

L’IA non è solo una nuova area di attacco da difendere, ma anche un nuovo e potente strumento di sicurezza. I modelli di machine learning possono rilevare cambiamenti sottili che nessun umano può vedere in montagne di traffico di rete.

La sicurezza ama la chiarezza

La trasparenza è un componente chiave di qualsiasi strategia di sicurezza. Lasciare che i clienti sappiano di eventuali nuove politiche e pratiche di sicurezza AI che sono state messe in atto.

Definire percorsi, non destinazioni

Questi sei passaggi sono solo l’inizio di un viaggio. I processi e le politiche come questi devono evolversi. È essenziale tenere d’occhio l’orizzonte per le migliori pratiche e gli strumenti man mano che arrivano.

In conclusione, NVIDIA sottolinea l’importanza di un approccio proattivo e evolutivo alla sicurezza AI, enfatizzando la necessità di estendere e adattare le pratiche esistenti per affrontare le nuove sfide poste dall’IA.